[Cilium] Cilium ServiceMesh

들어가며

이번 포스트에서는 ServiceMesh이란 무엇인가와 등장배경을 알아보고, Cilium에서 제공하는 ServiceMesh의 각 기능들에 대해 실습을 통하여 알아보도록 하겠습니다.

실습 환경 구성

- 이번 실습에서는 다음의 구성으로 실습 환경을 구성합니다.

- 버전 : Kubernetes 1.33.4, Cilium 1.18.1, pwru

-

기본 배포 가상 머신 : k8s-ctr, k8s-w1, router

- k8s-ctr spec : vCPU 4, Mem 2560

- k8s-w1 spec : vCPU 4, Mem 2560

- router : router : 192.168.10.0/24 ↔ 192.168.20.0/24 대역 라우팅 역할, k8s 에 join 되지 않은 서버입니다.

- 실습 동작에 필요한 static routing이 설저된 상태로 배포 됩니다.

실습환경 배포 파일

-

Vagrantfile : 가상머신 정의, 부팅 시 초기 프로비저닝 설정을 포함하는 Vagrantfile입니다.

# Variables K8SV = '1.33.4-1.1' # Kubernetes Version : apt list -a kubelet , ex) 1.32.5-1.1 CONTAINERDV = '1.7.27-1' # Containerd Version : apt list -a containerd.io , ex) 1.6.33-1 CILIUMV = '1.18.1' # Cilium CNI Version : https://github.com/cilium/cilium/tags N = 1 # max number of worker nodes # Base Image https://portal.cloud.hashicorp.com/vagrant/discover/bento/ubuntu-24.04 BOX_IMAGE = "bento/ubuntu-24.04" BOX_VERSION = "202508.03.0" Vagrant.configure("2") do |config| #-ControlPlane Node config.vm.define "k8s-ctr" do |subconfig| subconfig.vm.box = BOX_IMAGE subconfig.vm.box_version = BOX_VERSION subconfig.vm.provider "virtualbox" do |vb| vb.customize ["modifyvm", :id, "--groups", "/Cilium-Lab"] vb.customize ["modifyvm", :id, "--nicpromisc2", "allow-all"] vb.name = "k8s-ctr" vb.cpus = 2 vb.memory = 2560 vb.linked_clone = true end subconfig.vm.host_name = "k8s-ctr" subconfig.vm.network "private_network", ip: "192.168.10.100" subconfig.vm.network "forwarded_port", guest: 22, host: 60000, auto_correct: true, id: "ssh" subconfig.vm.synced_folder "./", "/vagrant", disabled: true subconfig.vm.provision "shell", path: "init_cfg.sh", args: [ K8SV, CONTAINERDV ] subconfig.vm.provision "shell", path: "k8s-ctr.sh", args: [ N, CILIUMV, K8SV ] subconfig.vm.provision "shell", path: "route-add1.sh" end #-Worker Nodes Subnet1 (1..N).each do |i| config.vm.define "k8s-w#{i}" do |subconfig| subconfig.vm.box = BOX_IMAGE subconfig.vm.box_version = BOX_VERSION subconfig.vm.provider "virtualbox" do |vb| vb.customize ["modifyvm", :id, "--groups", "/Cilium-Lab"] vb.customize ["modifyvm", :id, "--nicpromisc2", "allow-all"] vb.name = "k8s-w#{i}" vb.cpus = 2 vb.memory = 1536 vb.linked_clone = true end subconfig.vm.host_name = "k8s-w#{i}" subconfig.vm.network "private_network", ip: "192.168.10.10#{i}" subconfig.vm.network "forwarded_port", guest: 22, host: "6000#{i}", auto_correct: true, id: "ssh" subconfig.vm.synced_folder "./", "/vagrant", disabled: true subconfig.vm.provision "shell", path: "init_cfg.sh", args: [ K8SV, CONTAINERDV] subconfig.vm.provision "shell", path: "k8s-w.sh" subconfig.vm.provision "shell", path: "route-add1.sh" end end #-Router Node config.vm.define "router" do |subconfig| subconfig.vm.box = BOX_IMAGE subconfig.vm.box_version = BOX_VERSION subconfig.vm.provider "virtualbox" do |vb| vb.customize ["modifyvm", :id, "--groups", "/Cilium-Lab"] vb.name = "router" vb.cpus = 1 vb.memory = 768 vb.linked_clone = true end subconfig.vm.host_name = "router" subconfig.vm.network "private_network", ip: "192.168.10.200" subconfig.vm.network "forwarded_port", guest: 22, host: 60009, auto_correct: true, id: "ssh" subconfig.vm.network "private_network", ip: "192.168.20.200", auto_config: false subconfig.vm.synced_folder "./", "/vagrant", disabled: true subconfig.vm.provision "shell", path: "router.sh" end end -

init_cfg.sh : args 참고하여 초기 설정을 수행하는 스크립트입니다. pwru도 설치합니다.

#!/usr/bin/env bash echo ">>>> Initial Config Start <<<<" echo "[TASK 1] Setting Profile & Bashrc" echo 'alias vi=vim' >> /etc/profile echo "sudo su -" >> /home/vagrant/.bashrc ln -sf /usr/share/zoneinfo/Asia/Seoul /etc/localtime # Change Timezone echo "[TASK 2] Disable AppArmor" systemctl stop ufw && systemctl disable ufw >/dev/null 2>&1 systemctl stop apparmor && systemctl disable apparmor >/dev/null 2>&1 echo "[TASK 3] Disable and turn off SWAP" swapoff -a && sed -i '/swap/s/^/#/' /etc/fstab echo "[TASK 4] Install Packages" apt update -qq >/dev/null 2>&1 apt-get install apt-transport-https ca-certificates curl gpg -y -qq >/dev/null 2>&1 # Download the public signing key for the Kubernetes package repositories. mkdir -p -m 755 /etc/apt/keyrings K8SMMV=$(echo $1 | sed -En 's/^([0-9]+\.[0-9]+)\..*/\1/p') curl -fsSL https://pkgs.k8s.io/core:/stable:/v$K8SMMV/deb/Release.key | sudo gpg --dearmor -o /etc/apt/keyrings/kubernetes-apt-keyring.gpg echo "deb [signed-by=/etc/apt/keyrings/kubernetes-apt-keyring.gpg] https://pkgs.k8s.io/core:/stable:/v$K8SMMV/deb/ /" >> /etc/apt/sources.list.d/kubernetes.list curl -fsSL https://download.docker.com/linux/ubuntu/gpg -o /etc/apt/keyrings/docker.asc echo "deb [arch=$(dpkg --print-architecture) signed-by=/etc/apt/keyrings/docker.asc] https://download.docker.com/linux/ubuntu $(. /etc/os-release && echo "$VERSION_CODENAME") stable" | tee /etc/apt/sources.list.d/docker.list > /dev/null # packets traversing the bridge are processed by iptables for filtering echo 1 > /proc/sys/net/ipv4/ip_forward echo "net.ipv4.ip_forward = 1" >> /etc/sysctl.d/k8s.conf # enable br_netfilter for iptables modprobe br_netfilter modprobe overlay echo "br_netfilter" >> /etc/modules-load.d/k8s.conf echo "overlay" >> /etc/modules-load.d/k8s.conf echo "[TASK 5] Install Kubernetes components (kubeadm, kubelet and kubectl)" # Update the apt package index, install kubelet, kubeadm and kubectl, and pin their version apt update >/dev/null 2>&1 # apt list -a kubelet ; apt list -a containerd.io apt-get install -y kubelet=$1 kubectl=$1 kubeadm=$1 containerd.io=$2 >/dev/null 2>&1 apt-mark hold kubelet kubeadm kubectl >/dev/null 2>&1 # containerd configure to default and cgroup managed by systemd containerd config default > /etc/containerd/config.toml sed -i 's/SystemdCgroup = false/SystemdCgroup = true/g' /etc/containerd/config.toml # avoid WARN&ERRO(default endpoints) when crictl run cat <<EOF > /etc/crictl.yaml runtime-endpoint: unix:///run/containerd/containerd.sock image-endpoint: unix:///run/containerd/containerd.sock EOF # ready to install for k8s systemctl restart containerd && systemctl enable containerd systemctl enable --now kubelet echo "[TASK 6] Install Packages & Helm" export DEBIAN_FRONTEND=noninteractive apt-get install -y bridge-utils sshpass net-tools conntrack ngrep tcpdump ipset arping wireguard jq yq tree bash-completion unzip kubecolor termshark >/dev/null 2>&1 curl -s https://raw.githubusercontent.com/helm/helm/master/scripts/get-helm-3 | bash >/dev/null 2>&1 echo "[TASK 7] Install pwru" CLI_ARCH=amd64 if [ "$(uname -m)" = "aarch64" ]; then CLI_ARCH=arm64; fi wget https://github.com/cilium/pwru/releases/download/v1.0.10/pwru-linux-${CLI_ARCH}.tar.gz >/dev/null 2>&1 tar -xvzf pwru-linux-${CLI_ARCH}.tar.gz >/dev/null 2>&1 mv pwru /usr/local/bin/pwru >/dev/null 2>&1 # echo "[TASK 8] Change MTU for eth1" # ip link set dev eth1 mtu 9000 echo ">>>> Initial Config End <<<<" -

k8s-ctr.sh : kubeadm init를 통하여 kubernetes controlplane 노드를 설정하고 Cilium CNI 설치, 편리성 설정(k, kc, k9s)하는 스크립트입니다. local-path-storageclass와 metrics-server도 설치합니다.

#!/usr/bin/env bash echo ">>>> K8S Controlplane config Start <<<<" echo "[TASK 1] Initial Kubernetes" curl --silent -o /root/kubeadm-init-ctr-config.yaml https://raw.githubusercontent.com/gasida/vagrant-lab/refs/heads/main/cilium-study/kubeadm-init-ctr-config.yaml K8SMMV=$(echo $3 | sed -En 's/^([0-9]+\.[0-9]+\.[0-9]+).*/\1/p') sed -i "s/K8S_VERSION_PLACEHOLDER/v${K8SMMV}/g" /root/kubeadm-init-ctr-config.yaml kubeadm init --config="/root/kubeadm-init-ctr-config.yaml" >/dev/null 2>&1 echo "[TASK 2] Setting kube config file" mkdir -p /root/.kube cp -i /etc/kubernetes/admin.conf /root/.kube/config chown $(id -u):$(id -g) /root/.kube/config echo "[TASK 3] Source the completion" echo 'source <(kubectl completion bash)' >> /etc/profile echo 'source <(kubeadm completion bash)' >> /etc/profile echo "[TASK 4] Alias kubectl to k" echo 'alias k=kubectl' >> /etc/profile echo 'alias kc=kubecolor' >> /etc/profile echo 'complete -F __start_kubectl k' >> /etc/profile echo "[TASK 5] Install Kubectx & Kubens" git clone https://github.com/ahmetb/kubectx /opt/kubectx >/dev/null 2>&1 ln -s /opt/kubectx/kubens /usr/local/bin/kubens ln -s /opt/kubectx/kubectx /usr/local/bin/kubectx echo "[TASK 6] Install Kubeps & Setting PS1" git clone https://github.com/jonmosco/kube-ps1.git /root/kube-ps1 >/dev/null 2>&1 cat <<"EOT" >> /root/.bash_profile source /root/kube-ps1/kube-ps1.sh KUBE_PS1_SYMBOL_ENABLE=true function get_cluster_short() { echo "$1" | cut -d . -f1 } KUBE_PS1_CLUSTER_FUNCTION=get_cluster_short KUBE_PS1_SUFFIX=') ' PS1='$(kube_ps1)'$PS1 EOT kubectl config rename-context "kubernetes-admin@kubernetes" "HomeLab" >/dev/null 2>&1 echo "[TASK 7] Install Cilium CNI" NODEIP=$(ip -4 addr show eth1 | grep -oP '(?<=inet\s)\d+(\.\d+){3}') helm repo add cilium https://helm.cilium.io/ >/dev/null 2>&1 helm repo update >/dev/null 2>&1 helm install cilium cilium/cilium --version $2 --namespace kube-system \ --set k8sServiceHost=192.168.10.100 --set k8sServicePort=6443 \ --set ipam.mode="cluster-pool" --set ipam.operator.clusterPoolIPv4PodCIDRList={"172.20.0.0/16"} --set ipv4NativeRoutingCIDR=172.20.0.0/16 \ --set routingMode=native --set autoDirectNodeRoutes=true --set endpointRoutes.enabled=true --set directRoutingSkipUnreachable=true \ --set kubeProxyReplacement=true --set bpf.masquerade=true --set installNoConntrackIptablesRules=true \ --set endpointHealthChecking.enabled=false --set healthChecking=false \ --set hubble.enabled=true --set hubble.relay.enabled=true --set hubble.ui.enabled=true \ --set hubble.ui.service.type=NodePort --set hubble.ui.service.nodePort=30003 \ --set prometheus.enabled=true --set operator.prometheus.enabled=true --set hubble.metrics.enableOpenMetrics=true \ --set hubble.metrics.enabled="{dns,drop,tcp,flow,port-distribution,icmp,httpV2:exemplars=true;labelsContext=source_ip\,source_namespace\,source_workload\,destination_ip\,destination_namespace\,destination_workload\,traffic_direction}" \ --set ingressController.enabled=true --set ingressController.loadbalancerMode=shared --set loadBalancer.l7.backend=envoy \ --set localRedirectPolicy=true --set l2announcements.enabled=true \ --set operator.replicas=1 --set debug.enabled=true >/dev/null 2>&1 echo "[TASK 8] Install Cilium / Hubble CLI" CILIUM_CLI_VERSION=$(curl -s https://raw.githubusercontent.com/cilium/cilium-cli/main/stable.txt) CLI_ARCH=amd64 if [ "$(uname -m)" = "aarch64" ]; then CLI_ARCH=arm64; fi curl -L --fail --remote-name-all https://github.com/cilium/cilium-cli/releases/download/${CILIUM_CLI_VERSION}/cilium-linux-${CLI_ARCH}.tar.gz >/dev/null 2>&1 tar xzvfC cilium-linux-${CLI_ARCH}.tar.gz /usr/local/bin rm cilium-linux-${CLI_ARCH}.tar.gz HUBBLE_VERSION=$(curl -s https://raw.githubusercontent.com/cilium/hubble/master/stable.txt) HUBBLE_ARCH=amd64 if [ "$(uname -m)" = "aarch64" ]; then HUBBLE_ARCH=arm64; fi curl -L --fail --remote-name-all https://github.com/cilium/hubble/releases/download/$HUBBLE_VERSION/hubble-linux-${HUBBLE_ARCH}.tar.gz >/dev/null 2>&1 tar xzvfC hubble-linux-${HUBBLE_ARCH}.tar.gz /usr/local/bin rm hubble-linux-${HUBBLE_ARCH}.tar.gz echo "[TASK 9] Remove node taint" kubectl taint nodes k8s-ctr node-role.kubernetes.io/control-plane- echo "[TASK 10] local DNS with hosts file" echo "192.168.10.100 k8s-ctr" >> /etc/hosts echo "192.168.10.200 router" >> /etc/hosts echo "192.168.20.100 k8s-w0" >> /etc/hosts for (( i=1; i<=$1; i++ )); do echo "192.168.10.10$i k8s-w$i" >> /etc/hosts; done echo "[TASK 11] Dynamically provisioning persistent local storage with Kubernetes" kubectl apply -f https://raw.githubusercontent.com/rancher/local-path-provisioner/v0.0.31/deploy/local-path-storage.yaml >/dev/null 2>&1 kubectl patch storageclass local-path -p '{"metadata": {"annotations":{"storageclass.kubernetes.io/is-default-class":"true"}}}' >/dev/null 2>&1 # echo "[TASK 12] Install Prometheus & Grafana" # kubectl apply -f https://raw.githubusercontent.com/cilium/cilium/1.18.0/examples/kubernetes/addons/prometheus/monitoring-example.yaml >/dev/null 2>&1 # kubectl patch svc -n cilium-monitoring prometheus -p '{"spec": {"type": "NodePort", "ports": [{"port": 9090, "targetPort": 9090, "nodePort": 30001}]}}' >/dev/null 2>&1 # kubectl patch svc -n cilium-monitoring grafana -p '{"spec": {"type": "NodePort", "ports": [{"port": 3000, "targetPort": 3000, "nodePort": 30002}]}}' >/dev/null 2>&1 # echo "[TASK 12] Install Prometheus Stack" # helm repo add prometheus-community https://prometheus-community.github.io/helm-charts >/dev/null 2>&1 # cat <<EOT > monitor-values.yaml # prometheus: # prometheusSpec: # scrapeInterval: "15s" # evaluationInterval: "15s" # service: # type: NodePort # nodePort: 30001 # grafana: # defaultDashboardsTimezone: Asia/Seoul # adminPassword: prom-operator # service: # type: NodePort # nodePort: 30002 # alertmanager: # enabled: false # defaultRules: # create: false # prometheus-windows-exporter: # prometheus: # monitor: # enabled: false # EOT # helm install kube-prometheus-stack prometheus-community/kube-prometheus-stack --version 75.15.1 \ # -f monitor-values.yaml --create-namespace --namespace monitoring >/dev/null 2>&1 echo "[TASK 13] Install Metrics-server" helm repo add metrics-server https://kubernetes-sigs.github.io/metrics-server/ >/dev/null 2>&1 helm upgrade --install metrics-server metrics-server/metrics-server --set 'args[0]=--kubelet-insecure-tls' -n kube-system >/dev/null 2>&1 echo "[TASK 14] Install k9s" CLI_ARCH=amd64 if [ "$(uname -m)" = "aarch64" ]; then CLI_ARCH=arm64; fi wget https://github.com/derailed/k9s/releases/latest/download/k9s_linux_${CLI_ARCH}.deb -O /tmp/k9s_linux_${CLI_ARCH}.deb >/dev/null 2>&1 apt install /tmp/k9s_linux_${CLI_ARCH}.deb >/dev/null 2>&1 echo ">>>> K8S Controlplane Config End <<<<"-

kubeadm-init-ctr-config.yaml

apiVersion: kubeadm.k8s.io/v1beta4 kind: InitConfiguration bootstrapTokens: - token: "123456.1234567890123456" ttl: "0s" usages: - signing - authentication localAPIEndpoint: advertiseAddress: "192.168.10.100" nodeRegistration: kubeletExtraArgs: - name: node-ip value: "192.168.10.100" criSocket: "unix:///run/containerd/containerd.sock" --- apiVersion: kubeadm.k8s.io/v1beta4 kind: ClusterConfiguration kubernetesVersion: "K8S_VERSION_PLACEHOLDER" networking: podSubnet: "10.244.0.0/16" serviceSubnet: "10.96.0.0/16" proxy: disabled: true

-

-

k8s-w.sh : kubernetes worker 노드 설정, kubeadm join 등을 수행하는 스크립트입니다.

#!/usr/bin/env bash echo ">>>> K8S Node config Start <<<<" echo "[TASK 1] K8S Controlplane Join" curl --silent -o /root/kubeadm-join-worker-config.yaml https://raw.githubusercontent.com/gasida/vagrant-lab/refs/heads/main/cilium-study/2w/kubeadm-join-worker-config.yaml NODEIP=$(ip -4 addr show eth1 | grep -oP '(?<=inet\s)\d+(\.\d+){3}') sed -i "s/NODE_IP_PLACEHOLDER/${NODEIP}/g" /root/kubeadm-join-worker-config.yaml kubeadm join --config="/root/kubeadm-join-worker-config.yaml" > /dev/null 2>&1 echo ">>>> K8S Node config End <<<<"-

kubeadm-join-worker-config.yaml

apiVersion: kubeadm.k8s.io/v1beta4 kind: JoinConfiguration discovery: bootstrapToken: token: "123456.1234567890123456" apiServerEndpoint: "192.168.10.100:6443" unsafeSkipCAVerification: true nodeRegistration: criSocket: "unix:///run/containerd/containerd.sock" kubeletExtraArgs: - name: node-ip value: "NODE_IP_PLACEHOLDER"

-

-

route-add1.sh : k8s node 들이 내부망과 통신을 위한 route 설정 스크립트입니다.

#!/usr/bin/env bash echo ">>>> Route Add Config Start <<<<" chmod 600 /etc/netplan/01-netcfg.yaml chmod 600 /etc/netplan/50-vagrant.yaml cat <<EOT>> /etc/netplan/50-vagrant.yaml routes: - to: 192.168.20.0/24 via: 192.168.10.200 EOT netplan apply echo ">>>> Route Add Config End <<<<" -

router.sh : router 역할, 간단 웹 서버 역할

#!/usr/bin/env bash echo ">>>> Initial Config Start <<<<" echo "[TASK 0] Setting eth2" chmod 600 /etc/netplan/01-netcfg.yaml chmod 600 /etc/netplan/50-vagrant.yaml cat << EOT >> /etc/netplan/50-vagrant.yaml eth2: addresses: - 192.168.20.200/24 EOT netplan apply echo "[TASK 1] Setting Profile & Bashrc" echo 'alias vi=vim' >> /etc/profile echo "sudo su -" >> /home/vagrant/.bashrc ln -sf /usr/share/zoneinfo/Asia/Seoul /etc/localtime echo "[TASK 2] Disable AppArmor" systemctl stop ufw && systemctl disable ufw >/dev/null 2>&1 systemctl stop apparmor && systemctl disable apparmor >/dev/null 2>&1 echo "[TASK 3] Add Kernel setting - IP Forwarding" sed -i 's/#net.ipv4.ip_forward=1/net.ipv4.ip_forward=1/g' /etc/sysctl.conf sysctl -p >/dev/null 2>&1 echo "[TASK 5] Install Packages" export DEBIAN_FRONTEND=noninteractive apt update -qq >/dev/null 2>&1 apt-get install net-tools jq yq tree ngrep tcpdump arping termshark -y -qq >/dev/null 2>&1 echo "[TASK 6] Install Apache" apt install apache2 -y >/dev/null 2>&1 echo -e "<h1>Web Server : $(hostname)</h1>" > /var/www/html/index.html echo ">>>> Initial Config End <<<<"

실습환경 배포

실습환경 배포

$ vagrant up

기본정보 확인

#

$ cat /etc/hosts

# => ...

# 127.0.2.1 k8s-ctr k8s-ctr

# 192.168.10.100 k8s-ctr

# 192.168.10.200 router

# 192.168.20.100 k8s-w0

# 192.168.10.101 k8s-w1

$ for i in k8s-w1 router ; do echo ">> node : $i <<"; sshpass -p 'vagrant' ssh -o StrictHostKeyChecking=no vagrant@$i hostname; echo; done

# => >> node : k8s-w1 <<

# k8s-w1

# >> node : router <<

# router

# 클러스터 정보 확인

$ kubectl cluster-info

# => Kubernetes control plane is running at https://192.168.10.100:6443

# CoreDNS is running at https://192.168.10.100:6443/api/v1/namespaces/kube-system/services/kube-dns:dns/proxy

$ kubectl cluster-info dump | grep -m 2 -E "cluster-cidr|service-cluster-ip-range"

# => "--service-cluster-ip-range=10.96.0.0/16",

# "--cluster-cidr=10.244.0.0/16",

$ kubectl describe cm -n kube-system kubeadm-config

# => ...

# networking:

# dnsDomain: cluster.local

# podSubnet: 10.244.0.0/16

# serviceSubnet: 10.96.0.0/16

$ kubectl describe cm -n kube-system kubelet-config

# 노드 정보 : 상태, INTERNAL-IP 확인

$ ifconfig | grep -iEA1 'eth[0-9]:'

# => eth0: flags=4163<UP,BROADCAST,RUNNING,MULTICAST> mtu 1500

# inet 10.0.2.15 netmask 255.255.255.0 broadcast 10.0.2.255

# --

# eth1: flags=4163<UP,BROADCAST,RUNNING,MULTICAST> mtu 1500

# inet 192.168.10.100 netmask 255.255.255.0 broadcast 192.168.10.255

$ kubectl get node -owide

# => NAME STATUS ROLES AGE VERSION INTERNAL-IP EXTERNAL-IP OS-IMAGE KERNEL-VERSION CONTAINER-RUNTIME

# k8s-ctr Ready control-plane 15m v1.33.4 192.168.10.100 <none> Ubuntu 24.04.2 LTS 6.8.0-71-generic containerd://1.7.27

# k8s-w1 Ready <none> 12m v1.33.4 192.168.10.101 <none> Ubuntu 24.04.2 LTS 6.8.0-71-generic containerd://1.7.27

# 파드 정보 : 상태, 파드 IP 확인

$ kubectl get nodes -o jsonpath='{range .items[*]}{.metadata.name}{"\t"}{.spec.podCIDR}{"\n"}{end}'

# => k8s-ctr 10.244.0.0/24

# k8s-w1 10.244.1.0/24

$ kubectl get ciliumnode -o json | grep podCIDRs -A2

# => "podCIDRs": [

# "172.20.0.0/24"

# ],

# --

# "podCIDRs": [

# "172.20.1.0/24"

# ],

$ kubectl get pod -A -owide

# => NAMESPACE NAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE READINESS GATES

# kube-system cilium-2zkt5 1/1 Running 0 12m 192.168.10.101 k8s-w1 <none> <none>

# kube-system cilium-8gt4t 1/1 Running 0 15m 192.168.10.100 k8s-ctr <none> <none>

# kube-system cilium-envoy-jhcs2 1/1 Running 0 12m 192.168.10.101 k8s-w1 <none> <none>

# kube-system cilium-envoy-txqxb 1/1 Running 0 15m 192.168.10.100 k8s-ctr <none> <none>

# kube-system cilium-operator-7b4884dcdd-j5hnz 1/1 Running 0 15m 192.168.10.100 k8s-ctr <none> <none>

# kube-system hubble-relay-fdd49b976-wdn8n 1/1 Running 0 15m 172.20.0.78 k8s-ctr <none> <none>

# kube-system hubble-ui-655f947f96-gv9rw 2/2 Running 0 15m 172.20.0.220 k8s-ctr <none> <none>

# local-path-storage local-path-provisioner-74f9666bc9-c944v 1/1 Running 0 14m 172.20.0.176 k8s-ctr <none> <none>

# ...

$ kubectl get ciliumendpoints -A

# => NAMESPACE NAME SECURITY IDENTITY ENDPOINT STATE IPV4 IPV6

# kube-system coredns-674b8bbfcf-2qlch 24463 ready 172.20.0.158

# kube-system coredns-674b8bbfcf-ltzx4 24463 ready 172.20.0.157

# kube-system hubble-relay-fdd49b976-wdn8n 16977 ready 172.20.0.78

# kube-system hubble-ui-655f947f96-gv9rw 40085 ready 172.20.0.220

# kube-system metrics-server-5dd7b49d79-9rlxq 931 ready 172.20.0.4

# local-path-storage local-path-provisioner-74f9666bc9-c944v 9074 ready 172.20.0.176

# ipam 모드 확인

$ cilium config view | grep ^ipam

# => ipam cluster-pool

# ipam-cilium-node-update-rate 15s

# iptables 확인 : TPROXY 관련 규칙 찾아보자!

$ iptables-save

$ iptables -t nat -S

$ iptables -t filter -S

$ iptables -t mangle -S

$ iptables -t raw -S

# 아래 iptables 룰들은 Pod ↔ Proxy ↔ 외부/내부 서비스 트래픽이 올바르게 프록시를 거치되, 커널 conntrack에 의해 방해받지 않도록 제어 by ChatGPT

$ iptables -t mangle -S | grep -i proxy

# => # "Pod로 가는 트래픽 중 proxy를 거쳐야 하는 경우" 패킷을 식별하기 위해 마킹. 이후 TPROXY 룰에서 이 마크(0x200)를 보고 프록시로 리다이렉션.

# -A CILIUM_PRE_mangle ! -o lo -m socket --transparent -m mark ! --mark 0xe00/0xf00 -m mark ! --mark 0x800/0xf00 -m comment --comment "cilium: any->pod redirect proxied traffic to host proxy" -j MARK --set-xmark 0x200/0xffffffff

# # Pod에서 나가는 DNS 요청(UDP/TCP 53) 을 Cilium host proxy(Envoy 기반)로 강제로 보내어[TPROXY로 리다이렉션 → 127.0.0.1:38715 (Cilium DNS egress proxy 포트)] L7 정책 적용 가능하게 만듦.

# -A CILIUM_PRE_mangle -p tcp -m mark --mark 0xd9800200 -m comment --comment "cilium: TPROXY to host cilium-dns-egress proxy" -j TPROXY --on-port 32985 --on-ip 127.0.0.1 --tproxy-mark 0x200/0xffffffff

# -A CILIUM_PRE_mangle -p udp -m mark --mark 0xd9800200 -m comment --comment "cilium: TPROXY to host cilium-dns-egress proxy" -j TPROXY --on-port 32985 --on-ip 127.0.0.1 --tproxy-mark 0x200/0xffffffff

$ iptables -t raw -S | grep -i proxy

# => # 프록시에서 나가는 리턴 트래픽은 NAT/conntrack이 꼬이지 않게 conntrack에서 제외. 즉, proxy ↔ pod 간 트래픽은 BPF가 직접 상태 관리.

# -A CILIUM_OUTPUT_raw -o lxc+ -m mark --mark 0xa00/0xfffffeff -m comment --comment "cilium: NOTRACK for proxy return traffic" -j CT --notrack

# -A CILIUM_OUTPUT_raw -o cilium_host -m mark --mark 0xa00/0xfffffeff -m comment --comment "cilium: NOTRACK for proxy return traffic" -j CT --notrack

# # L7 proxy(Envoy) → upstream(원래 목적지) 트래픽도 conntrack에서 제외.

# # 이유: Proxy는 자체적으로 연결 추적을 수행하므로 커널 conntrack과 이중 관리되면 충돌/성능 저하 발생.

# -A CILIUM_OUTPUT_raw -o lxc+ -m mark --mark 0x800/0xe00 -m comment --comment "cilium: NOTRACK for L7 proxy upstream traffic" -j CT --notrack

# -A CILIUM_OUTPUT_raw -o cilium_host -m mark --mark 0x800/0xe00 -m comment --comment "cilium: NOTRACK for L7 proxy upstream traffic" -j CT --notrack

# # 앞에서 설명한 "proxy로 리다이렉션된 트래픽" 자체도 conntrack에서 제외.

# # Proxy 앞뒤 트래픽 모두 커널 conntrack 대신 Cilium/BPF/Envoy가 관리.

# -A CILIUM_PRE_raw -m mark --mark 0x200/0xf00 -m comment --comment "cilium: NOTRACK for proxy traffic" -j CT --notrack

[k8s-ctr] Cilium 설치 정보 확인

# cilium 상태 확인

$ kubectl get cm -n kube-system cilium-config -o json | jq

$ cilium status

$ cilium config view | grep -E '^loadbalancer|l7'

# => enable-l7-proxy true

# loadbalancer-l7 envoy

# loadbalancer-l7-algorithm round_robin

# loadbalancer-l7-ports

#

$ kubectl exec -n kube-system -c cilium-agent -it ds/cilium -- cilium-dbg status --verbose

$ kubectl exec -n kube-system -c cilium-agent -it ds/cilium -- cilium-dbg metrics list

샘플 애플리케이션 배포 및 통신 문제 확인

샘플 애플리케이션 배포

# 샘플 애플리케이션 배포

$ cat << EOF | kubectl apply -f -

apiVersion: apps/v1

kind: Deployment

metadata:

name: webpod

spec:

replicas: 2

selector:

matchLabels:

app: webpod

template:

metadata:

labels:

app: webpod

spec:

affinity:

podAntiAffinity:

requiredDuringSchedulingIgnoredDuringExecution:

- labelSelector:

matchExpressions:

- key: app

operator: In

values:

- sample-app

topologyKey: "kubernetes.io/hostname"

containers:

- name: webpod

image: traefik/whoami

ports:

- containerPort: 80

---

apiVersion: v1

kind: Service

metadata:

name: webpod

labels:

app: webpod

spec:

selector:

app: webpod

ports:

- protocol: TCP

port: 80

targetPort: 80

type: ClusterIP

EOF

# => deployment.apps/webpod created

# service/webpod created

# k8s-ctr 노드에 curl-pod 파드 배포

$ cat <<EOF | kubectl apply -f -

apiVersion: v1

kind: Pod

metadata:

name: curl-pod

labels:

app: curl

spec:

nodeName: k8s-ctr

containers:

- name: curl

image: nicolaka/netshoot

command: ["tail"]

args: ["-f", "/dev/null"]

terminationGracePeriodSeconds: 0

EOF

# => pod/curl-pod created

통신 확인

# 배포 확인

$ kubectl get deploy,svc,ep webpod -owide

# => NAME READY UP-TO-DATE AVAILABLE AGE CONTAINERS IMAGES SELECTOR

# deployment.apps/webpod 2/2 2 2 27s webpod traefik/whoami app=webpod

# NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE SELECTOR

# service/webpod ClusterIP 10.96.234.83 <none> 80/TCP 27s app=webpod

# NAME ENDPOINTS AGE

# endpoints/webpod 172.20.0.111:80,172.20.1.212:80 27s

$ kubectl get endpointslices -l app=webpod

$ kubectl get ciliumendpoints # IP 확인

# => NAME SECURITY IDENTITY ENDPOINT STATE IPV4 IPV6

# curl-pod 10893 ready 172.20.0.209

# webpod-697b545f57-gsp8r 11530 ready 172.20.1.212

# webpod-697b545f57-pwvhp 11530 ready 172.20.0.111

# 통신 문제 확인

$ kubectl exec -it curl-pod -- curl -s --connect-timeout 1 webpod | grep Hostname

$ kubectl exec -it curl-pod -- sh -c 'while true; do curl -s --connect-timeout 1 webpod | grep Hostname; echo "---" ; sleep 1; done'

# => Hostname: webpod-697b545f57-gsp8r

# ---

# Hostname: webpod-697b545f57-pwvhp

# ---

# Hostname: webpod-697b545f57-pwvhp

# ...

# <span style="color: green;">👉 통신 문제가 없습니다!</span>

# cilium-dbg, map

$ kubectl exec -n kube-system ds/cilium -- cilium-dbg ip list

$ kubectl exec -n kube-system ds/cilium -- cilium-dbg endpoint list

$ kubectl exec -n kube-system ds/cilium -- cilium-dbg service list

$ kubectl exec -n kube-system ds/cilium -- cilium-dbg bpf lb list

$ kubectl exec -n kube-system ds/cilium -- cilium-dbg bpf nat list

$ kubectl exec -n kube-system ds/cilium -- cilium-dbg map list | grep -v '0 0'

$ kubectl exec -n kube-system ds/cilium -- cilium-dbg map get cilium_lb4_services_v2

$ kubectl exec -n kube-system ds/cilium -- cilium-dbg map get cilium_lb4_backends_v3

$ kubectl exec -n kube-system ds/cilium -- cilium-dbg map get cilium_lb4_reverse_nat

$ kubectl exec -n kube-system ds/cilium -- cilium-dbg map get cilium_ipcache_v2

pwru 간단 실습

- 로우레벨의 정보까지 모니터링 가능한 pwru(Packet, Where Are You)를 통해 차단 이유를 확인해 보는 실습을 진행해보겠습니다.

# 다운로드 https://github.com/cilium/pwru/releases : script 로 다운로드 되어 있음.

$ wget https://github.com/cilium/pwru/releases/download/v1.0.10/pwru-linux-arm64.tar.gz

$ tar -xvzf pwru-linux-arm64.tar.gz

$ mv pwru /usr/bin

$ pwru -h

# 1.1.1.1 목적지 차단 설정

$ iptables -t filter -I OUTPUT 1 -m tcp --proto tcp --dst 1.1.1.1/32 -j DROP

# curl 호출 : 아래 모니터링 후 호출

$ curl 1.1.1.1 -v

# pwru 모니터링 : 차단 이유 확인! SKB_DROP_REASON_NETFILTER_DROP

$ pwru 'dst host 1.1.1.1 and tcp and dst port 80'

# => 2025/08/21 23:45:36 Attaching kprobes (via kprobe)...

# 1667 / 1667 [----------------------------------------------------------] 100.00% 1270 p/s

# 2025/08/21 23:45:38 Attached (ignored 5)

# 2025/08/21 23:45:38 Listening for events..

# SKB CPU PROCESS NETNS MARK/x IFACE PROTO MTU LEN TUPLE FUNC

# 0xffff000004cb58e8 3 ~r/bin/curl:8493 4026531840 0 0 0x0000 1500 60 10.0.2.15:60880->1.1.1.1:80(tcp) __ip_local_out

# 0xffff000004cb58e8 3 ~r/bin/curl:8493 4026531840 0 0 0x0800 1500 60 10.0.2.15:60880->1.1.1.1:80(tcp) nf_hook_slow

# 0xffff000004cb58e8 3 ~r/bin/curl:8493 4026531840 0 0 0x0800 1500 60 10.0.2.15:60880->1.1.1.1:80(tcp)

# kfree_skb_reason(<span style="color: green;">SKB_DROP_REASON_NETFILTER_DROP</span>)

# <span style="color: green;">👉 NETFILER에 의해 차단(DROP)됨을 확인할 수 있습니다.</span>

# 0xffff000004cb58e8 3 ~r/bin/curl:8493 4026531840 0 0 0x0800 1500 60 10.0.2.15:60880->1.1.1.1:80(tcp) skb_release_head_state

# 0xffff000004cb58e8 3 ~r/bin/curl:8493 4026531840 0 0 0x0800 0 60 10.0.2.15:60880->1.1.1.1:80(tcp) tcp_wfree

# 0xffff000004cb58e8 3 ~r/bin/curl:8493 4026531840 0 0 0x0800 0 60 10.0.2.15:60880->1.1.1.1:80(tcp) skb_release_data

# 0xffff000004cb58e8 3 ~r/bin/curl:8493 4026531840 0 0 0x0800 0 60 10.0.2.15:60880->1.1.1.1:80(tcp) kfree_skbmem

# 0xffff000004cb58e8 3 <empty>:0 4026531840 0 0 0x0800 0 60 10.0.2.15:60880->1.1.1.1:80(tcp) __skb_clone

# 0xffff000004cb58e8 3 <empty>:0 0 0 0 0x0800 0 60 10.0.2.15:60880->1.1.1.1:80(tcp) __copy_skb_header

# 0xffff000004cb58e8 3 <empty>:0 4026531840 0 0 0x0000 1500 60 10.0.2.15:60880->1.1.1.1:80(tcp) __ip_local_out

# 0xffff000004cb58e8 3 <empty>:0 4026531840 0 0 0x0800 1500 60 10.0.2.15:60880->1.1.1.1:80(tcp) nf_hook_slow

# 0xffff000004cb58e8 3 <empty>:0 4026531840 0 0 0x0800 1500 60 10.0.2.15:60880->1.1.1.1:80(tcp)

# kfree_skb_reason(<span style="color: green;">SKB_DROP_REASON_NETFILTER_DROP</span>)

# 0xffff000004cb58e8 3 <empty>:0 4026531840 0 0 0x0800 1500 60 10.0.2.15:60880->1.1.1.1:80(tcp) skb_release_head_state

# 0xffff000004cb58e8 3 <empty>:0 4026531840 0 0 0x0800 0 60 10.0.2.15:60880->1.1.1.1:80(tcp) tcp_wfree

# 0xffff000004cb58e8 3 <empty>:0 4026531840 0 0 0x0800 0 60 10.0.2.15:60880->1.1.1.1:80(tcp) skb_release_data

# 0xffff000004cb58e8 3 <empty>:0 4026531840 0 0 0x0800 0 60 10.0.2.15:60880->1.1.1.1:80(tcp) kfree_skbmem

# 0xffff000004cb58e8 3 <empty>:0 4026531840 0 0 0x0800 0 60 10.0.2.15:60880->1.1.1.1:80(tcp) __skb_clone

# 0xffff000004cb58e8 3 <empty>:0 0 0 0 0x0800 0 60 10.0.2.15:60880->1.1.1.1:80(tcp) __copy_skb_header

# 0xffff000004cb58e8 3 <empty>:0 4026531840 0 0 0x0000 1500 60 10.0.2.15:60880->1.1.1.1:80(tcp) __ip_local_out

# 0xffff000004cb58e8 3 <empty>:0 4026531840 0 0 0x0800 1500 60 10.0.2.15:60880->1.1.1.1:80(tcp) nf_hook_slow

# ^C2025/08/21 23:46:14 Received signal, exiting program..

# 2025/08/21 23:46:14 Detaching kprobes...

# 1662 / 1662 [------------------------------------------------------------------------------------------------------------------------------------------------------] 100.00% 33 p/s

- 통신이 잘 되는것을 확인하였고, 기본적인 점검을 마쳤으니 본격적으로 Cilium의 기능을 살펴보도록 하겠습니다.

Cilium Service Mesh

Service Mesh 소개

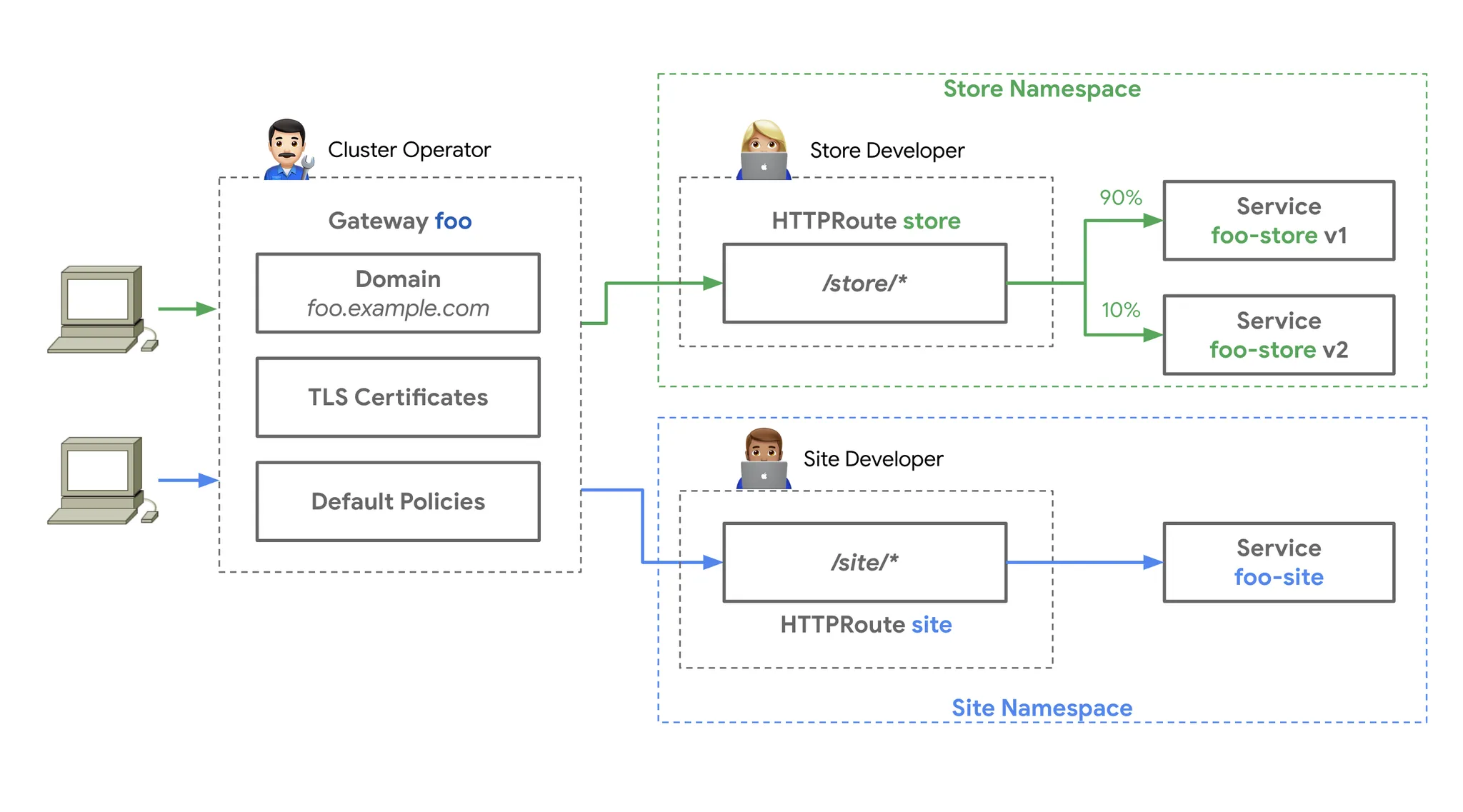

- Service Mesh는 마이크로서비스 아키텍처에서 서비스 간의 통신을 관리하고 모니터링하기 위한 인프라 계층입니다. 주로 L7 트래픽 관리, 보안, 모니터링, 로깅 등을 제공합니다.

- 등장 배경

- 기존에 하나의 모놀리식 애플리케이션이나 소수의 큰 서비스로 구성된 시스템에서는 서비스 간의 통신을 관리하기가 상대적으로 쉬웠습니다.

- 하지만 적게는 수십개, 많게는 수천개의 마이크로서비스가 존재하는 Micro Service Architecture 환경에서는 서비스 간의 통신을 관리하고 모니터링하기가 매우 복잡해집니다.

- MSA가 점점 보편화 됨에 따라 서비스 간의 통신을 관리하고 모니터링하기 위해 다음과 같은 기능이 필요하게 되었습니다.

- 서비스 디스커버리 : 서비스가 동적으로 생성되고 삭제되기 때문에, 서비스의 IP 주소나 포트등을 자동으로 찾아주는 기능

- 모니터링 : 서비스 간의 통신을 모니터링하고 성능을 측정하는 기능

- 로깅 : 서비스 간의 통신을 로깅하고 분석

- 트래픽 관리 : 서비스 간의 트래픽을 제어하고 관리하는 기능. Traffic Shifting, Circuit Breaker, Rate Limiting, Fault Injection 등의 기능을 포함

- 보안 : 서비스 간의 통신을 암호화하고 인증하는 기능

- 정책 관리 : 서비스 간의 통신을 제어하고 모니터링하기 위한 정책을 관리하는 기능

- 이러한 기능들을 서비스 단위로 언어별로 구현해야 했기에 복잡도가 증가하고, 코드 중복이 발생하게 됩니다.

- Service Mesh는 이러한 문제를 해결하기 위해 서비스 간의 통신을 관리하고 모니터링하기 위한 인프라 계층을 제공합니다. 이를 통해 개발자는 비즈니스 로직에 집중할 수 있고, 운영자는 서비스 간의 통신을 관리하고 모니터링하기가 쉬워집니다.

- 대표적인 Service Mesh에는 Istio, Linkerd, Consul 등이 있고, Cilium에서도 Cilium Service Mesh로 Service Mesh 기능을 제공합니다.

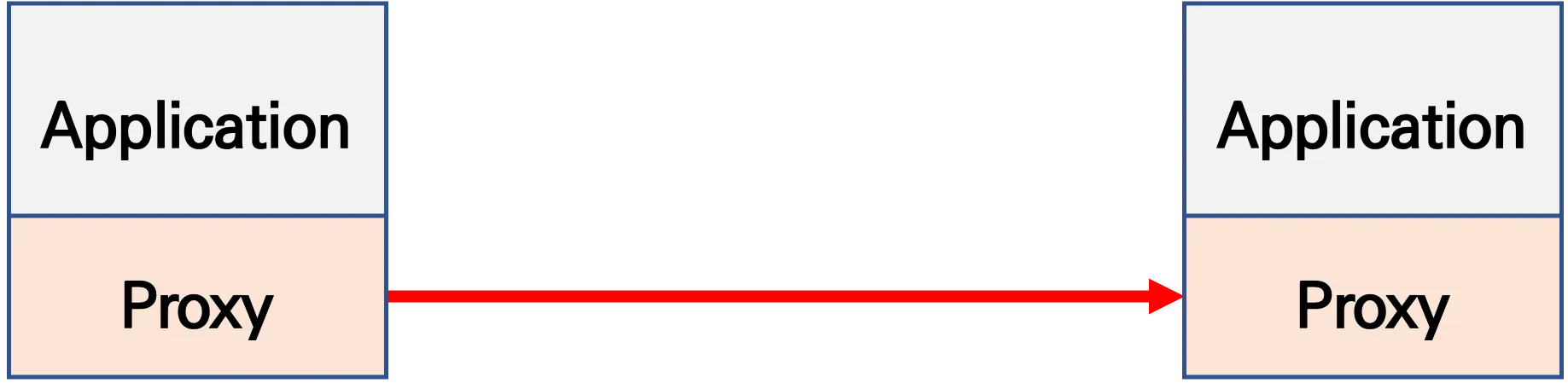

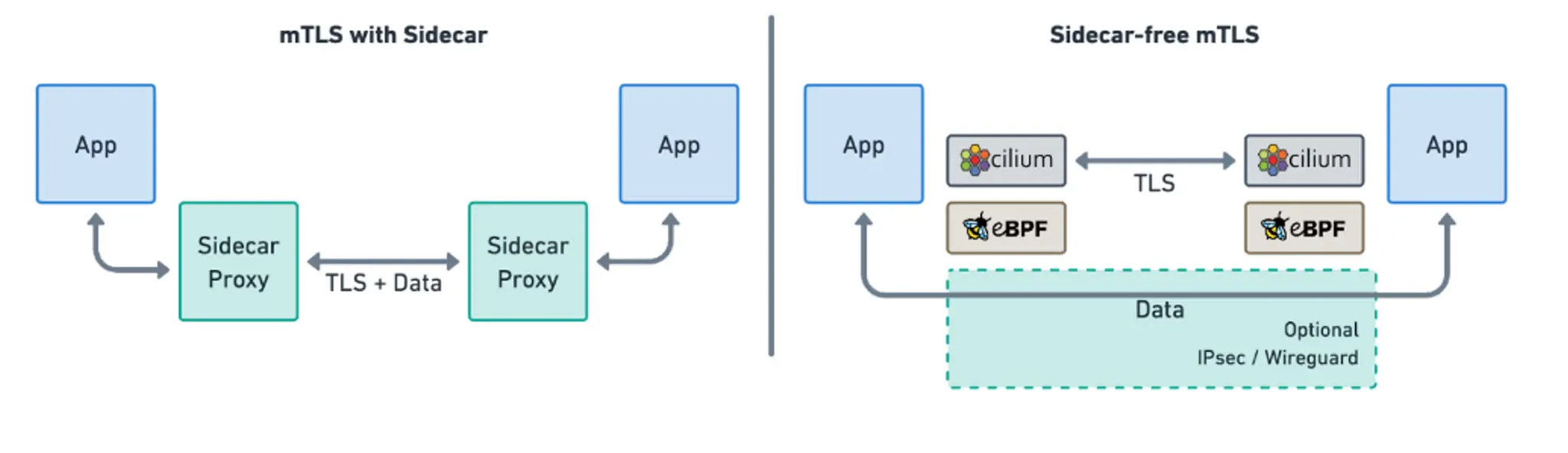

기본 동작

- 파드간 통신 경로에 프록시를 두고, 트래픽을 모니터링하고 제어하는 방식으로 동작합니다. 따라서 기존 애플리케이션 코드 변경 없이도 Service Mesh 기능을 사용할 수 있습니다.

- 기존 통신 환경

- Proxy를 도입하여, 애플리케이션 수정없이 모든 애플리케이션 통신을 프록시를 거치도록 합니다.

- 파드 내에 사이드카 컨테이너로 주입되어서 동작합니다.

- Proxy 컨테이너가 애플리케이션 트래픽을 가로채고, 이를 처리합니다.

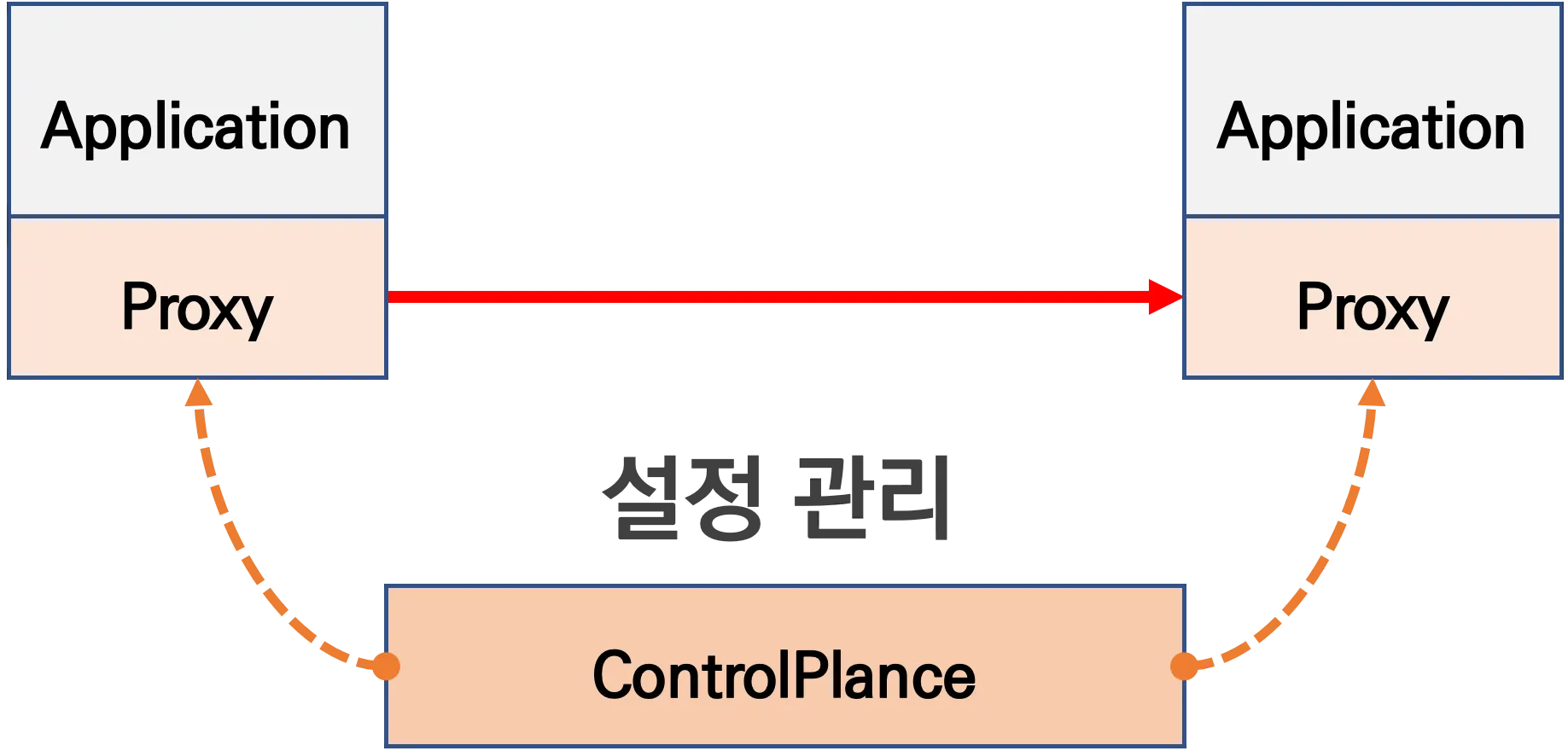

- Proxy는 DataPlane 역할을 하며, 이를 중앙에서 관리하는 ControlPlane을 두고 중앙에서 정책을 관리합니다.

- Proxy는 ControlPlane에서 설정을 관리하며, 설정관리가 유연하고 풍부한 API를 지원합니다.

- 대표적인 Service Mesh의 Proxy로는 Google, Ibm, Lyft가 중심이 되어 개발하고있는 Envoy가 있습니다.

- 네트워크 투명성을 목표로 하며, 다양한 필터체인 (L3/L4, HTTP L7)을 지원하며, 동적 구성 API, API 기반 hot reload를 제공합니다.

- 기존 통신 환경

- 트래픽 모니터링 : 요청의 에러율, 지연(latency), 컨넥션 개수, 요청 개수 등의 메트릭을 모니터링하며, 특정 서비스간 혹은 특정 요청 경로를 필터링해서 모니터링 할 수 있습니다.

-

트래픽 컨트롤

- 트래픽 시프팅(Traffic shifting) : 예시) 99% 기존앱 + 1% 신규앱, 특정 단말/사용자는 신규앱에 전달하여 단계적으로 적용하는 카나리 배포 기능

- 서킷 브레이커(Circuit Breaker) : 목적지 마이크로서비스에 문제가 있을 시 접속을 차단하고 출발지 마이크로서비스에 요청 에러를 반환하여 연쇄 장애, 시스템 전제 장애 예방합니다.

- 폴트 인젝션(Fault Injection) : 의도적으로 요청을 지연 혹은 실패를 구현합니다.

- 속도 제한(Rate Limit) : 요청 개수를 제한하여 서비스가 과부하와 리소스 고갈을 방지합니다.

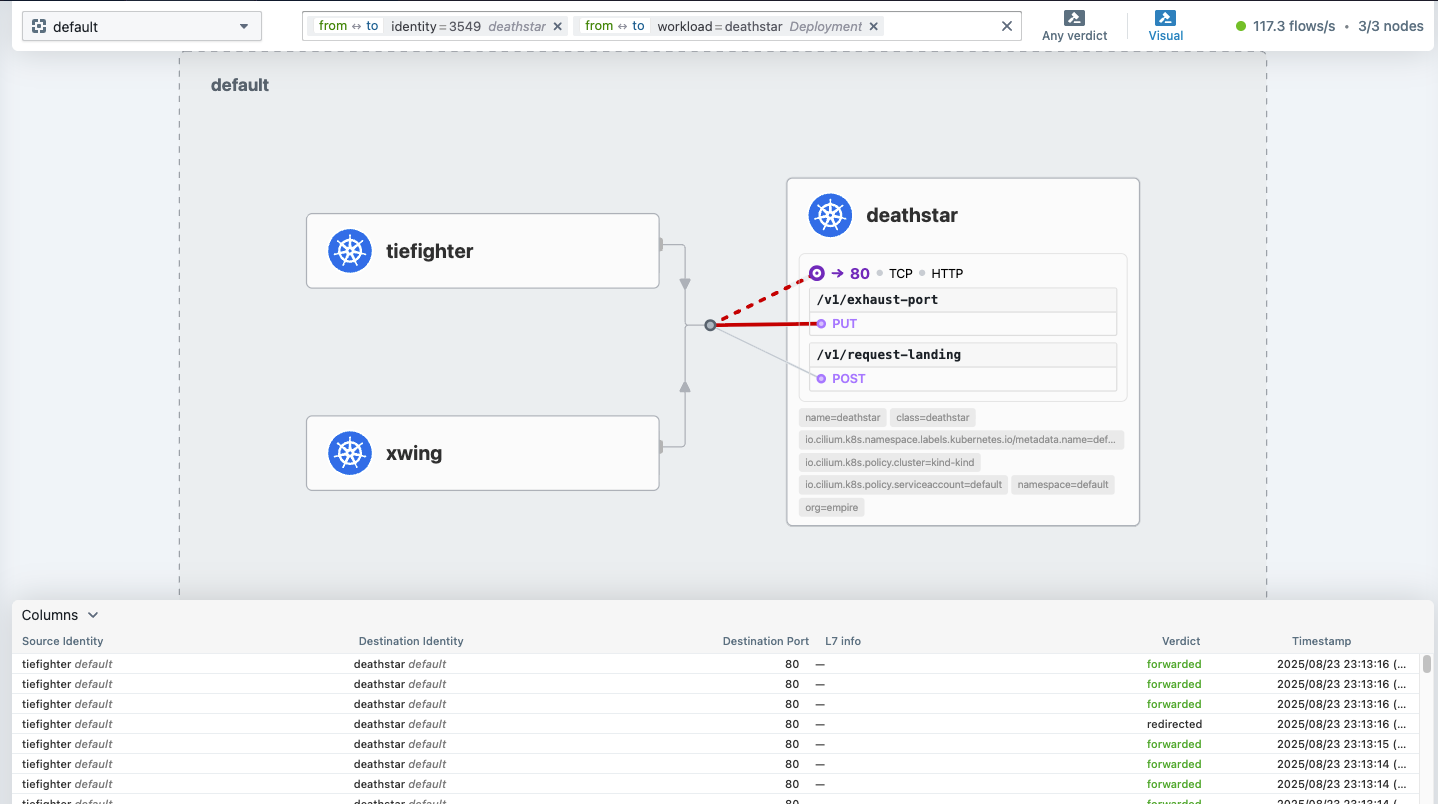

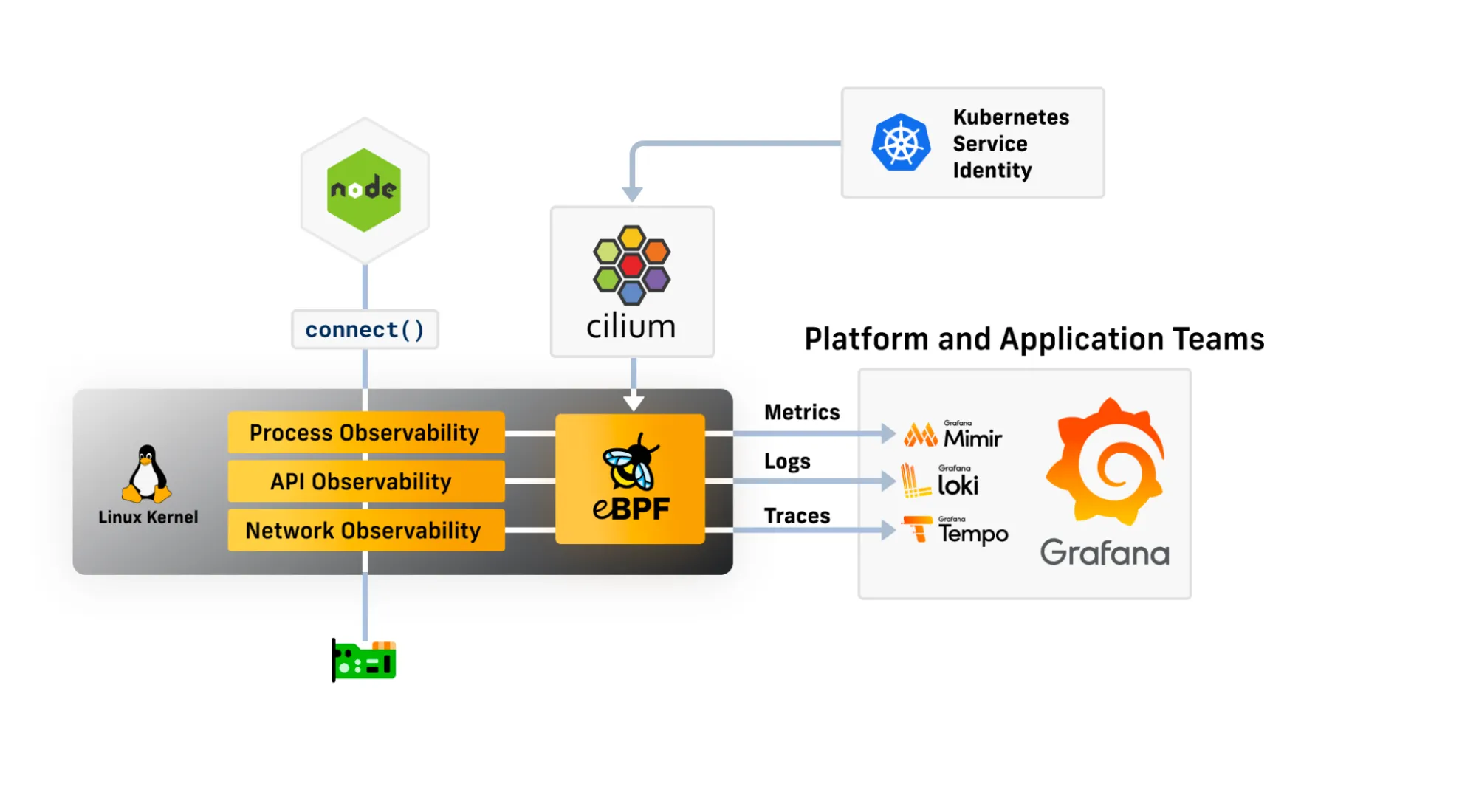

Cilium Service Mesh 소개

-

Docs, Youtube

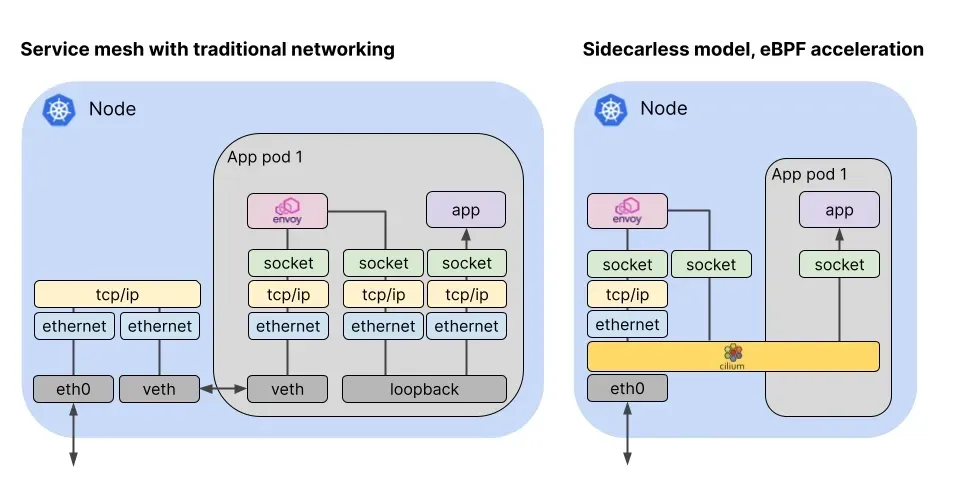

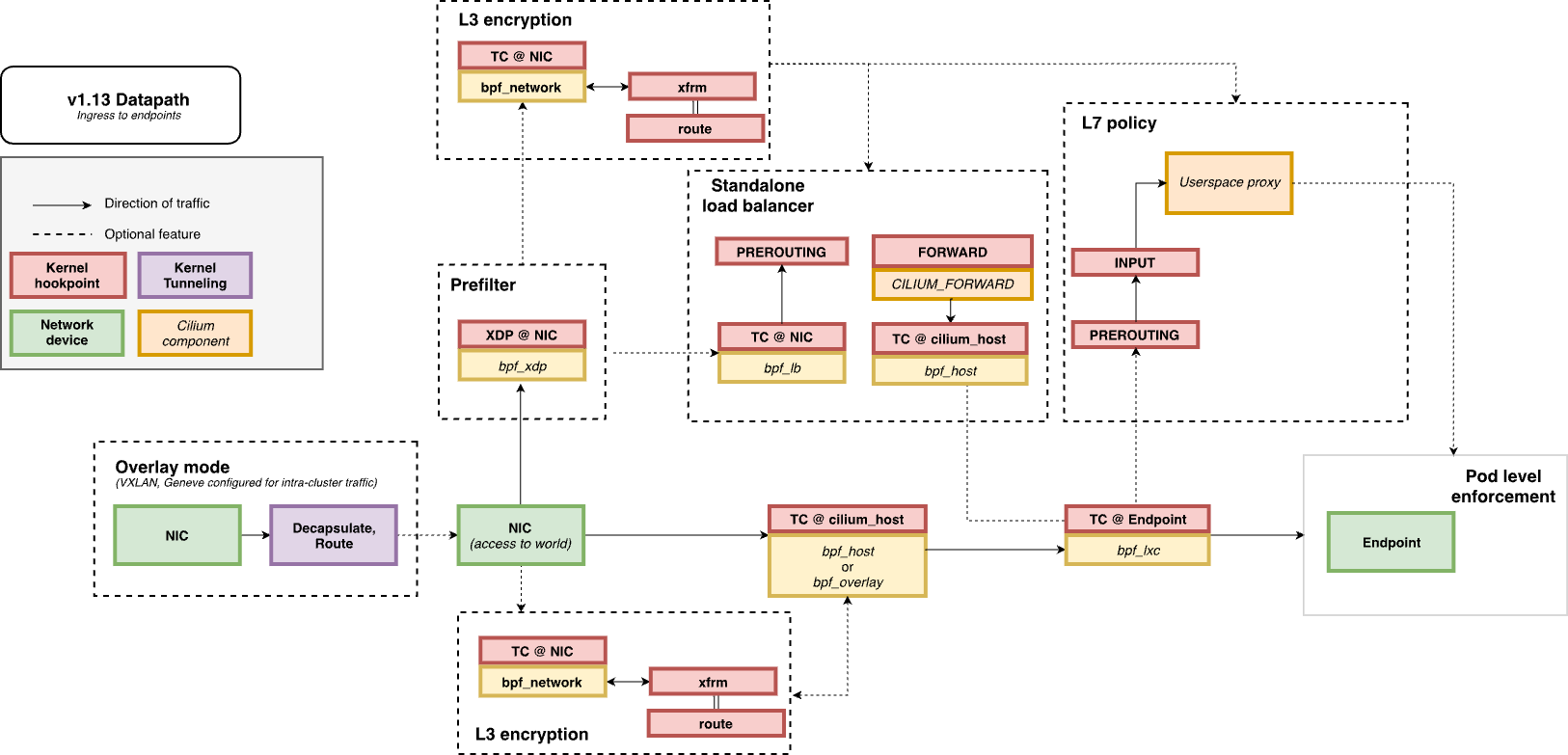

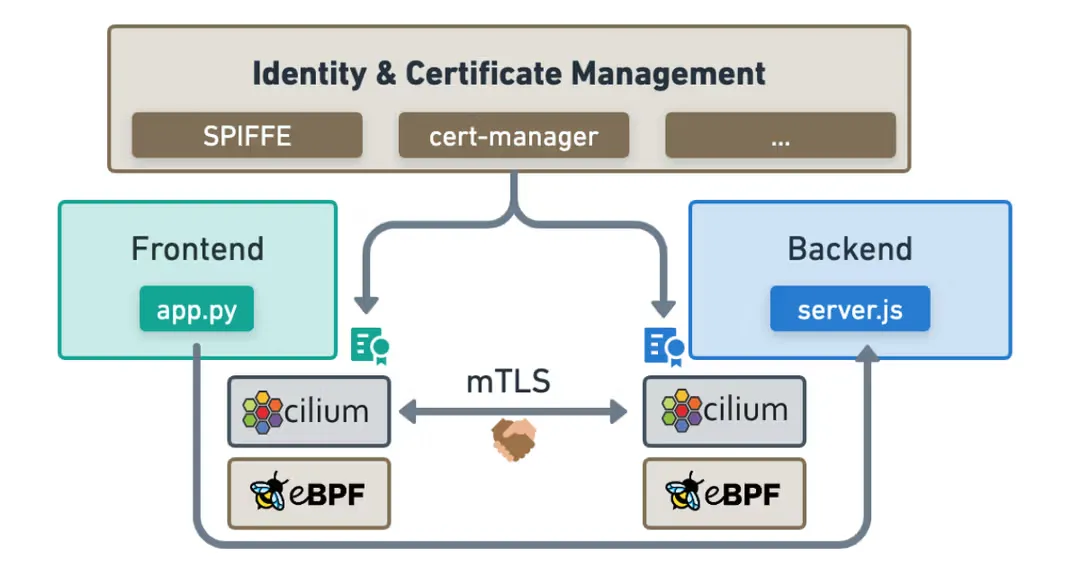

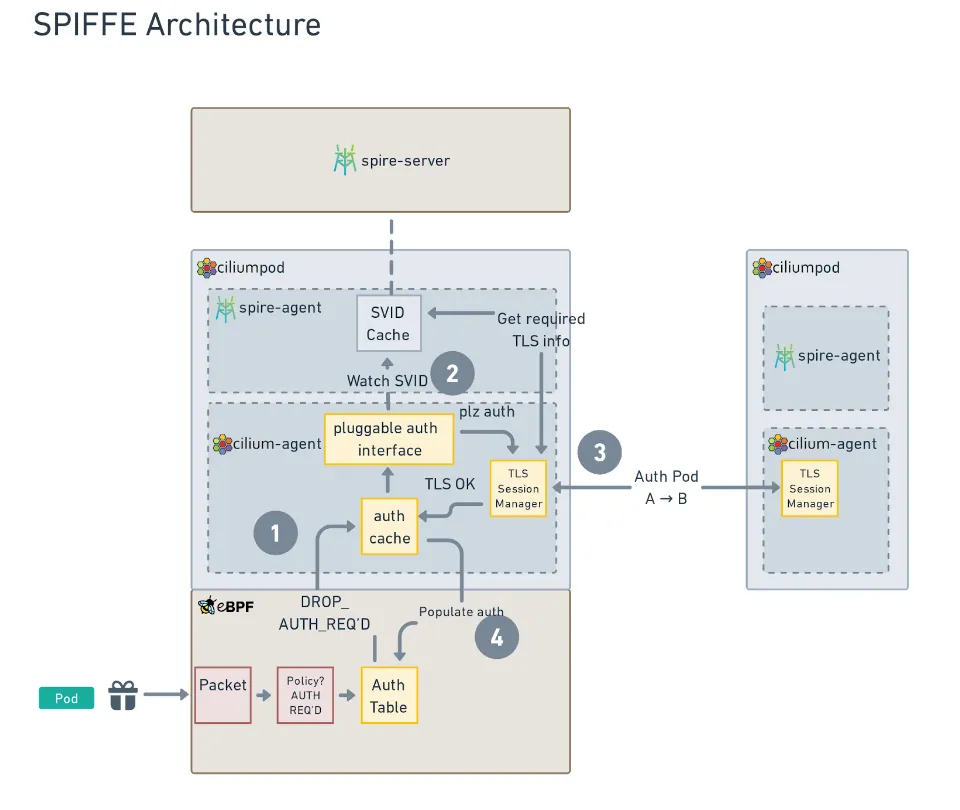

- Cilium Service Mesh는 Cilium의 eBPF 기반 네트워킹(L3/L4 담당)과 Envoy Proxy(L7 담당)를 결합하여 강력하고 유연한 Service Mesh 솔루션을 제공합니다.

-

L3/L4 수준 프로토콜 : eBPF가 수행

- IP, TCP, UDP 등 L3/L4 프로토콜을 지원하며, Cilium의 eBPF 기반 네트워킹 기능을 활용하여 고성능 트래픽 처리를 제공합니다.

- 위의 그림에서 보듯이, 기존의 Service Mesh는 L3/L4 트래픽을 처리하기 위해 iptables를 사용하고, 사이드카와 VETH를 통해서 트래픽을 가로채고 처리합니다. 이렇게 되면 TCP/IP 스택을 파드를 떠나기 전까지만도 3번이나 탐색해야 했습니다.

- Cilium Service Mesh는 eBPF를 통해 Proxy를 Host와 Kernel로 이동하고 사이드카를 제거하여, 트래픽을 가로채고 처리하는데 필요한 오버헤드를 최소화합니다.

-

L7 수준 프로토콜 : Envoy Proxy가 수행

- HTTP, Kafka, gRPC, DNS와 같은 애플리케이션 계층 프로토콜은 Envoy Proxy를 통해 처리됩니다.

- Cilium은 이미 타 Service Mesh에서 사이드카 형태로 사용하는 Envoy를 L7 정책이나 관측성(Observability) 기능을 위해 사용하고 있었습니다.

- 이미 Cilium이 Envoy를 사용하고 있기 때문에 자연스럽게 Service Mesh 기능을 추가할 수 있었습니다.

- 특히 다른 Service Mesh와 달리 Cilium Service Mesh는 Node당 하나의 Envoy Proxy만을 사용합니다.

- istiod의 Ambient 모드와 유사하지만, Cilium의 CNI 기능을 활용하여 더 효율적이고 통합된 구성을 제공합니다.

- HTTP, Kafka, gRPC, DNS와 같은 애플리케이션 계층 프로토콜은 Envoy Proxy를 통해 처리됩니다.

-

제공 기능

- 탄력적인 연결성(Resilient Connectivity): 서비스 간 통신은 클라우드, 클러스터, 온프레미스 등 경계를 넘어 가능해야 하며, 통신은 탄력적이고 장애 허용이 가능해야 합니다.

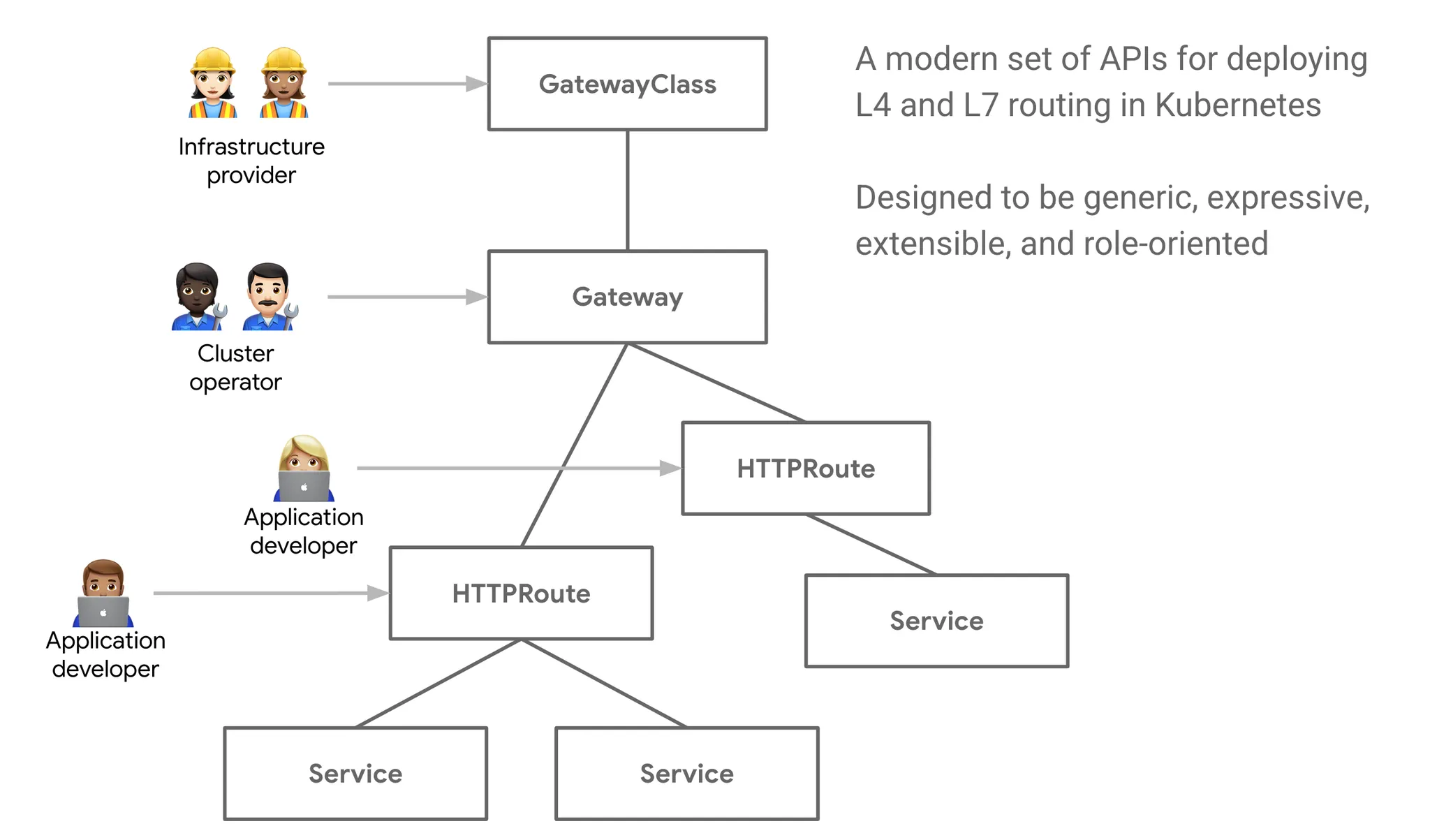

- L7 트래픽 관리(L7 Traffic Management): 로드 밸런싱, 속도 제한, 장애 복원력 등은 L7(HTTP, REST, gRPC, WebSocket 등)을 인식해야 합니다.

- ID 기반 보안(Identity-based Security): 네트워크 식별자에만 의존하는 보안은 더 이상 충분하지 않으며, 송신 및 수신 서비스 모두 네트워크 식별자가 아닌 ID 기반으로 상호 인증할 수 있어야 합니다.

- 관측성 및 트레이싱(Observability & Tracing): 트레이싱과 메트릭 형태의 관측성은 애플리케이션의 안정성, 성능, 가용성을 이해하고 모니터링하며 문제를 해결하는 데 매우 중요합니다.

- 투명성(Transparency): 이 기능들은 애플리케이션 코드를 변경하지 않고도 투명하게 제공되어야 합니다.

K8S Ingress Support

Cilium K8S Ingress Support 소개

- 관련문서

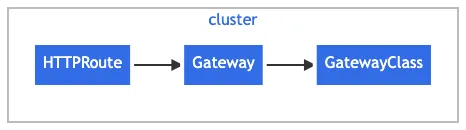

- Cilium은 Kubernetes Ingress resource definition을 지원하며

ingressClassName을 cilium으로 지정함으로써 사용할 수 있습니다. - 경로 기반 라우팅과 TLS termination을 지원합니다. 하위 호환을 위해서

kubernetes.io/ingress.class을 cilium으로 설정할 수도 있습니다. - Cilium Ingress Controller는 LoadBalancer Type의 Service로 배포되기 때문에, LoadBalancer를 지원하는 환경을 필요로 합니다.

- Cilium은 로드밸런서 모드를 다음 중 하나로 설정할 수 있습니다. 각 모드는 장단점이 있기 때문에 사용 환경에 따라 적절한 모드를 선택해야 합니다.

-

dedicated: 해당 ingress를 위해서 단독 로드밸런서를 사용합니다. 각 ingress마다 별도의 로드밸런서를 사용하기 때문에, 충돌이 발생하지 않습니다. 하지만 자원 낭비가 발생할 수 있습니다. -

shared: 모든 ingress들이 하나의 공통 로드밸런서를 공유합니다. 자원은 절약하지만 path prefix 충돌이 발생할 수 있습니다.

-

- 로드밸런서 모드는 변경이 가능하지만, 변경을 위해서는 LB IP 주소가 변경되어야 합니다. 따라서, 변경시 연결이 종료되며, 다운타임이 발생할 수 있습니다.

필수 조건

- Cilium은

nodePort.enabled=true로 설정되어 NodePort가 활성화되어 있거나kubeProxyReplacement=true를 통해 kube-proxy를 대체하는 경우에만 Ingress를 지원합니다. -

l7Proxy=true로 설정해서 L7 Proxy를 활성화해야 합니다. (기본값) - 기본적으로 LoadBalancer 타입의 Service로 배포되기 때문에, LoadBalancer를 지원하는 환경이 필요합니다. 다른 방법으로는 NodePort를 사용하거나, Cilium 1.16 이상 버전에서는 host network에 L7 Proxy를 배포할 수 있습니다.

Cilium Ingress와 Cilium Gateway API의 다른 Ingress Controller와의 차이점

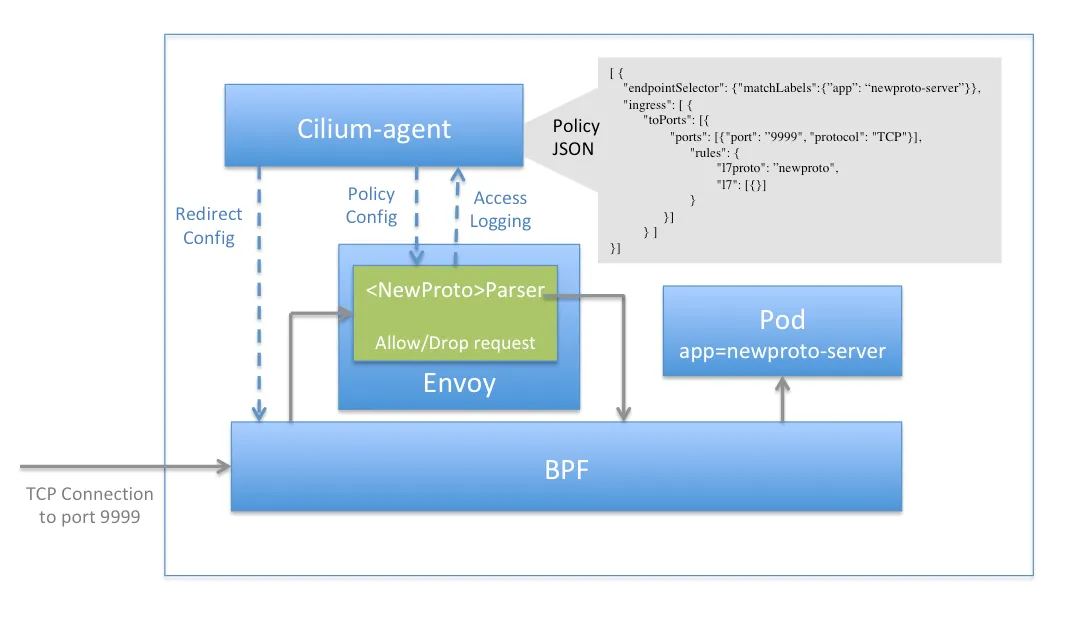

- CNI와의 밀접한 연결 : 다른 Ingress Controller는 CNI와 독립적으로 동작하지만, Cilium Ingress는 Cilium CNI와 밀접하게 통합되어 있습니다.

-

eBPF와 TPROXY를 사용하여 투명하게 Envoy에 전달 : 다른 Ingress Controller는 iptables를 사용하여 단순 포트포워딩을 통해 트래픽을 가로채지만, Cilium Ingress는 eBPF와 TPROXY를 사용하여 트래픽을 Envoy에 투명하게 전달합니다. 이를 통해 성능과 확장성이 향상됩니다.

- 이를 통해 Client IP Visibility 같은 문제를 해결 할 수 있으며, Cilium의 네트워크 정책 엔진이 Ingress를 통해 들어오는 트래픽에 Cilium Network Policy를 적용할 수 있도록 해줍니다.

- 동작 경로 : - [Client] → [K8s Node:Ingress/Gateway Service Port] → (eBPF Service LB) → (TPROXY) → [Envoy Proxy (Pod)] → (L7 라우팅/정책 처리) → (eBPF) → [Backend Pod]

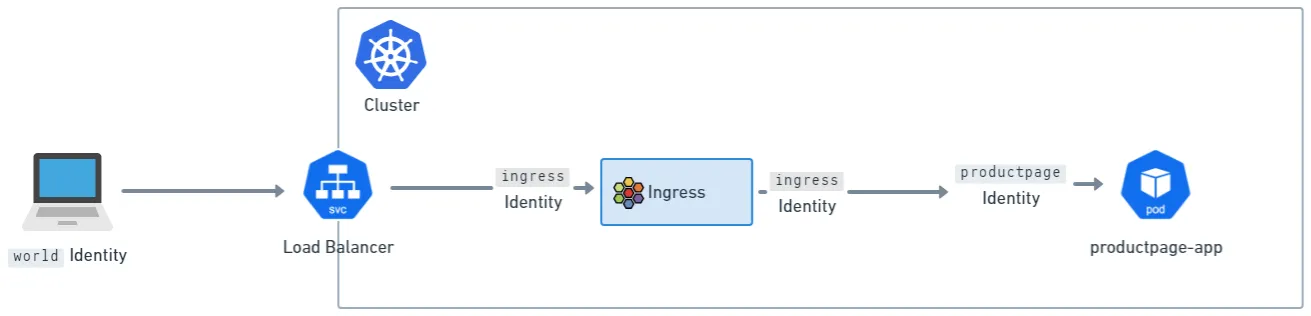

Cilium Ingress 구성 및 Cilium Network Policy

- 노드별 Envoy Proxy에 NetworkPolicy를 적용할 수 있습니다.

- Cilium을 통해 각 백엔드 서비스로 전송되는 Ingress와 Gateway API 트래픽은 각 노드별 Envoy Proxy를 통해 처리됩니다.

- 노드별 Envoy Proxy는 eBPF 정책 엔진과 상호작용할 수 있는 특수한 코드를 갖고 있으며, 트래픽에 대해 정책을 적용할 수 있습니다. 이를 통해 Envoy는 Ingress와 Gateway API 트래픽, east-west 트래픽에 대해서 Network Policy Enforcement Point로 작동할 수 있습니다.

- Envoy에 도착한 트래픽은 Cilium의 정책 엔진이 부여한 특수 ingress ID를 할당 받습니다.

- 클러스터 외부에서 들어오는 트래픽은 일반적으로 클러스터에 (IP CIDR 정책이 없는 한) world identity가 할당 됩니다.

- 이는 실제로 Cilium Ingress에 두개의 논리적 정책 집행 지점이 있다는것을 의미합니다.

- 즉, ingress identity에 트래픽이 도착하기 전과 노드별 Envoy를 통해 백엔드 서비스로 전달되기 전입니다.

- 이는 네트워크 정책을 클러스터에 적용할때 world에서 ingress로 들어갈때도 허용(allow)하고, ingress에서 클러스터의 identities (위의 그림에서는 productpage identity)로 전달될때도 동시에 허용(allow)해야 한다는 것을 의미합니다. Gateway API에서도 동일합니다.

Source IP Visibility

- 기본값으로 Cilium의 Envoy는 클라이언트의 IP 주소를

X-Forwarded-For헤더에 추가하여 백엔드 서비스로 전달합니다. 이를 통해 백엔드 서비스는 클라이언트의 실제 IP 주소를 알 수 있습니다. -

trusted hops를0을 기본값으로 설정하여, Envoy가X-Forwarded-For헤더의 값을 보는 대신, 연결이 시작된 실제 클라이언트 IP를 사용합니다. - 즉,

trusted hops를 증가 시킴으로써 Envoy가X-Forwarded-For의 오른쪽 부터 수를 세는 n번째 항목을 사용하게 할 수 있습니다. - Envoy는 또한

X-Envoy-External-Address헤더를 사용하여X-Forwarded-For를 기반으로한 신뢰할 수 있는 클라이언트의 주소를 전달합니다.

TLS Passthrough와 Source IP Visibility

- Ingress와 Gateway API는 모두 TLS Passthrough 구성을 지원합니다. (Ingress는 annotation을 통해, Gateway API는

TLSRoute리소스를 통해 지원합니다.) - 이 구성을 통해 여러 TLS Passthrough 백엔드가 Load Balancer에서 동일한 TLS 포트를 공유 할 수 있으며, Envoy는 TLS 핸드셰이크의 서버 이름 표시기(SNI)를 기반으로 백엔드를 선택합니다.

- 동작방식 : TLS 트래픽 -> Envoy에 도착 -> TCP 스트림 종료 -> Envoy가 클라이언트 hello를 검사하여 SNI를 찾고 백엔드 선택 -> ✨새로운 TCP 스트림 시작 -> 다운스트림(외부) 패킷 내부의 TLS 트래픽을 업스트림(백엔드)로 전달

- 하지만 이러한 동작은 Source IP Visibility 문제를 발생시킬수 있습니다. 왜냐하면 Envoy가 TLS 스트림의 TCP 프록시를 수행하고 있기 때문입니다.

- 새로운 TCP 스트림이 생기기 때문에 백엔드에서 바라본 소스 IP는 Envoy(Cilium 구성에 따라 Node IP인 경우가 많음)입니다.

- 즉, TLS Passthrough를 사용하면 백엔드는 Envoy의 IP 주소를 소스 IP로 받게되는 문제가 발생합니다.

Ingress Path Type과 우선순위

- Ingress 규격은 다음의 세가지 타입의 경로를 지원합니다.

- 정확한 값 (

Exact) : 경로가 정확히 일치해야 합니다. - 접두사 (

Prefix) : 경로가/로 구분되는 지정된 접두사로 시작해야 합니다.- 마지막 부분은 온전히 동일해야 합니다. 예를들어서 prefix가

/foo/bar인 경우/foo/bar/baz는 일치하지만/foo/barbaz는 일치하지 않습니다.

- 마지막 부분은 온전히 동일해야 합니다. 예를들어서 prefix가

- 구현 종속 (

ImplementationSpecific) : Ingress Controller에 따라 다르게 동작합니다.- Cilium Ingress의 경우에는

Regex, 즉, 정규표현식을 의미합니다.

- Cilium Ingress의 경우에는

- 정확한 값 (

- ingress에 대해서 여러 경로가 구성되어있으면 다음의 순서로 매칭합니다

- 정확한 값 (

Exact) - 구현 종속 (

ImplementationSpecific) - 접두사 (

Prefix) -

/접두사 처리

- 정확한 값 (

- 또한 동일한 경로 타입인 경우 경로의 길이가 긴 경로가 우선순위가 높습니다. 예를들어서

/foo/bar와/foo가 있을때/foo/bar가 우선순위가 높습니다. - 만약 구현 종속 방식을 사용한다면

*을 사용할때 주의가 필요합니다.*문자로 인해서 길이가 길어지지만, 실제 매칭되는 경로는 더 짧을 수 있습니다.- 예를들어서

/foo/bar/와/foo/bar/*가 있을때,/foo/bar/*는/foo/bar/에도 매칭이 되지만, 길이가 길어서/foo/bar/보다 우선순위가 높습니다. 이러한 경우 엉뚱한 백엔드로 트래픽이 전달될 수 있으니 주의해야 합니다.

- 예를들어서

- 추가적인 사항은 문서를 참고하시기 바랍니다. Docs

eBPF Datapath : Ingress to Endpoint

https://docs.cilium.io/en/stable/network/ebpf/lifeofapacket/#ingress-to-endpoint

https://docs.cilium.io/en/stable/network/ebpf/lifeofapacket/#ingress-to-endpoint

Cilium K8S Ingress Support 관련 정보 확인

- Cilium Ingress와 Cilium Gateway API는 동시 활성화가 불가능합니다. 단, 다른 Ingress Controller와 Cilium Gateway API는 함께 사용할 수 있습니다.

# cilium 설치 시 아래 파라미터 적용되어 있음

## --set ingressController.enabled=true

## --set ingressController.loadbalancerMode=shared

## --set loadBalancer.l7.backend=envoy \

$ cilium config view | grep -E '^loadbalancer|l7'

# => enable-l7-proxy true

# loadbalancer-l7 envoy

# loadbalancer-l7-algorithm round_robin

# loadbalancer-l7-ports

# ingress 에 예약된 내부 IP 확인 : node(cilium-envoy) 별로 존재

$ kubectl exec -it -n kube-system ds/cilium -- cilium ip list | grep ingress

# => 172.20.0.16/32 reserved:ingress

# 172.20.1.60/32 reserved:ingress

# cilium-envoy 확인

$ kubectl get ds -n kube-system cilium-envoy -owide

$ kubectl get pod -n kube-system -l k8s-app=cilium-envoy -owide

# => NAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE READINESS GATES

# cilium-envoy-b25zf 1/1 Running 0 2m50s 192.168.10.101 k8s-w1 <none> <none>

# cilium-envoy-hpsbc 1/1 Running 0 4m37s 192.168.10.100 k8s-ctr <none> <none>

$ kc describe pod -n kube-system -l k8s-app=cilium-envoy

# => ...

# Containers:

# cilium-envoy:

# Container ID: containerd://db82015552f31d7a16d8cada0883cdc7a4f75d39f36e76e0c582b10b1f3988e4

# Image: quay.io/cilium/cilium-envoy:v1.34.4-1754895458-68cffdfa568b6b226d70a7ef81fc65dda3b890bf@sha256:247e908700012f7ef56f75908f8c965215c26a27762f296068645eb55450bda2

# Image ID: quay.io/cilium/cilium-envoy@sha256:247e908700012f7ef56f75908f8c965215c26a27762f296068645eb55450bda2

# Port: 9964/TCP

# Host Port: 9964/TCP

# Command:

# /usr/bin/cilium-envoy-starter

# Args:

# --

# -c /var/run/cilium/envoy/bootstrap-config.json

# --base-id 0

# ...

# Mounts:

# /sys/fs/bpf from bpf-maps (rw)

# /var/run/cilium/envoy/ from envoy-config (ro)

# /var/run/cilium/envoy/artifacts from envoy-artifacts (ro)

# /var/run/cilium/envoy/sockets from envoy-sockets (rw)

# /var/run/secrets/kubernetes.io/serviceaccount from kube-api-access-jxsqh (ro)

# ...

# Volumes:

# envoy-sockets:

# Type: HostPath (bare host directory volume)

# Path: /var/run/cilium/envoy/sockets

# HostPathType: DirectoryOrCreate

# envoy-artifacts:

# Type: HostPath (bare host directory volume)

# Path: /var/run/cilium/envoy/artifacts

# HostPathType: DirectoryOrCreate

# envoy-config:

# Type: ConfigMap (a volume populated by a ConfigMap)

# Name: cilium-envoy-config

# Optional: false

# bpf-maps:

# Type: HostPath (bare host directory volume)

# Path: /sys/fs/bpf

# HostPathType: DirectoryOrCreate

# kube-api-access-jxsqh:

# Type: Projected (a volume that contains injected data from multiple sources)

# TokenExpirationSeconds: 3607

# ConfigMapName: kube-root-ca.crt

# Optional: false

# DownwardAPI: true

#

$ ls -al /var/run/cilium/envoy/sockets

# => ...

# srw-rw---- 1 root 1337 0 Aug 23 14:20 access_log.sock

# srwxr-xr-x 1 root root 0 Aug 23 14:19 admin.sock

# drwxr-xr-x 3 root root 60 Aug 23 14:20 envoy

# srw-rw---- 1 root 1337 0 Aug 23 14:20 xds.sock

#

$ kubectl exec -it -n kube-system ds/cilium-envoy -- ls -al /var/run/cilium/envoy

$ kubectl exec -it -n kube-system ds/cilium-envoy -- cat /var/run/cilium/envoy/bootstrap-config.json

$ kubectl exec -it -n kube-system ds/cilium-envoy -- cat /var/run/cilium/envoy/bootstrap-config.json > envoy.json

$ cat envoy.json | jq

# envoy configmap 설정 내용 확인

$ kubectl -n kube-system get configmap cilium-envoy-config

# => NAME DATA AGE

# cilium-envoy-config 1 7m54s

$ kubectl -n kube-system get configmap cilium-envoy-config -o json \

| jq -r '.data["bootstrap-config.json"]' \

| jq .

# => ...

# "admin": {

# "address": {

# "pipe": {

# "path": "/var/run/cilium/envoy/sockets/admin.sock"

# }

# }

# },

# ...

# "listeners": [

# {

# "address": {

# "socketAddress": {

# "address": "0.0.0.0",

# "portValue": 9964

# ...

$ tree /sys/fs/bpf

# => /sys/fs/bpf

# ├── cilium

# │ ├── devices

# │ │ ├── cilium_host

# │ │ │ └── links

# │ │ │ ├── cil_from_host

# │ │ │ └── cil_to_host

# │ │ ├── cilium_net

# │ │ │ └── links

# │ │ │ └── cil_to_host

# │ │ ├── eth0

# │ │ │ └── links

# │ │ │ ├── cil_from_netdev

# │ │ │ └── cil_to_netdev

# │ │ └── eth1

# │ │ └── links

# │ │ ├── cil_from_netdev

# │ │ └── cil_to_netdev

# │ ├── endpoints

# │ │ ├── 1019

# │ │ │ └── links

# │ │ │ ├── cil_from_container

# │ │ │ └── cil_to_container

# ...

#

$ kubectl get svc,ep -n kube-system cilium-envoy

# => NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE

# service/cilium-envoy ClusterIP None <none> 9964/TCP 9m24s

#

# NAME ENDPOINTS AGE

# endpoints/cilium-envoy 192.168.10.100:9964,192.168.10.101:9964 9m22s

#

$ kubectl get svc,ep -n kube-system cilium-ingress

# => NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE

# service/cilium-ingress LoadBalancer 10.96.58.190 <pending> 80:32243/TCP,443:30329/TCP 9m35s

#

# NAME ENDPOINTS AGE

# endpoints/cilium-ingress 192.192.192.192:9999 9m35s # Cilium → Envoy 간의 제어 채널(Control Plane), 외부 클라이언트가 접근하는 데이터 채널이 아님

LB-IPAM 설정 후 확인 : CiliumL2AnnouncementPolicy

# 현재 L2 Announcement 활성화 상태

$ cilium config view | grep l2

# => enable-l2-announcements true

# enable-l2-neigh-discovery false

# 충돌나지 않는지 대역 확인 할 것!

$ cat << EOF | kubectl apply -f -

apiVersion: "cilium.io/v2"

kind: CiliumLoadBalancerIPPool

metadata:

name: "cilium-lb-ippool"

spec:

blocks:

- start: "192.168.10.211"

stop: "192.168.10.215"

EOF

# => ciliumloadbalancerippool.cilium.io/cilium-lb-ippool created

$ kubectl get ippool

# => NAME DISABLED CONFLICTING IPS AVAILABLE AGE

# cilium-lb-ippool false False 4 7s

$ kubectl get ippools -o jsonpath='{.items[*].status.conditions[?(@.type!="cilium.io/PoolConflict")]}' | jq

# => {

# "lastTransitionTime": "2025-08-23T06:40:43Z",

# "message": "5",

# "observedGeneration": 1,

# "reason": "noreason",

# "status": "Unknown",

# "type": "cilium.io/IPsTotal"

# }

# {

# "lastTransitionTime": "2025-08-23T06:40:43Z",

# "message": "4",

# "observedGeneration": 1,

# "reason": "noreason",

# "status": "Unknown",

# "type": "cilium.io/IPsAvailable"

# }

# {

# "lastTransitionTime": "2025-08-23T06:40:43Z",

# "message": "1",

# "observedGeneration": 1,

# "reason": "noreason",

# "status": "Unknown",

# "type": "cilium.io/IPsUsed"

# }

# L2 Announcement 정책 설정

$ cat << EOF | kubectl apply -f -

apiVersion: "cilium.io/v2alpha1"

kind: CiliumL2AnnouncementPolicy

metadata:

name: policy1

spec:

interfaces:

- eth1

externalIPs: true

loadBalancerIPs: true

EOF

# => ciliuml2announcementpolicy.cilium.io/policy1 created

# 현재 리더 역할 노드 확인

$ kubectl -n kube-system get lease | grep "cilium-l2announce"

# => cilium-l2announce-kube-system-cilium-ingress k8s-w1 16s

$ kubectl -n kube-system get lease/cilium-l2announce-kube-system-cilium-ingress -o yaml | yq

# K8S 클러스터 내부 LB EX-IP로 호출 가능

$ LBIP=$(kubectl get svc -n kube-system cilium-ingress -o jsonpath='{.status.loadBalancer.ingress[0].ip}')

$ echo $LBIP

# => 192.168.10.211

$ arping -i eth1 $LBIP -c 2

# => ARPING 192.168.10.211

# 60 bytes from 08:00:27:12:18:4f (192.168.10.211): index=0 time=3.241 msec

# 60 bytes from 08:00:27:12:18:4f (192.168.10.211): index=1 time=184.759 usec

#

# --- 192.168.10.211 statistics ---

# 2 packets transmitted, 2 packets received, 0% unanswered (0 extra)

# rtt min/avg/max/std-dev = 0.185/1.713/3.241/1.528 ms

# k8s 외부 노드(router)에서 LB EX-IP로 호출 가능 확인

$ sshpass -p 'vagrant' ssh vagrant@router sudo arping -i eth1 $LBIP -c 2

# => ARPING 192.168.10.211

# 60 bytes from 08:00:27:12:18:4f (192.168.10.211): index=0 time=385.109 usec

# 60 bytes from 08:00:27:12:18:4f (192.168.10.211): index=1 time=384.192 usec

#

# --- 192.168.10.211 statistics ---

# 2 packets transmitted, 2 packets received, 0% unanswered (0 extra)

# rtt min/avg/max/std-dev = 0.384/0.385/0.385/0.000 ms

# <span style="color: green;">👉 k8s 외부 노드에서 LB EX-IP로 호출 가능합니다.</span>

Ingress HTTP Example : XFF 확인

# Deploy the Demo App : 공식 문서는 release-1.11 로 ARM CPU 에서 실패한다. 1.26 버전을 높여서 샘플 배포 할 것!

$ kubectl apply -f https://raw.githubusercontent.com/istio/istio/release-1.26/samples/bookinfo/platform/kube/bookinfo.yaml

# => ...

# service/productpage created

# serviceaccount/bookinfo-productpage created

# deployment.apps/productpage-v1 created

$ kubectl get pod,svc,ep

# => NAME READY STATUS RESTARTS AGE

# pod/details-v1-766844796b-fwxlh <span style="color: green;">1/1</span> Running 0 81s

# pod/productpage-v1-54bb874995-5zh9b <span style="color: green;">1/1</span> Running 0 81s

# pod/ratings-v1-5dc79b6bcd-l4fw4 <span style="color: green;">1/1</span> Running 0 81s

# pod/reviews-v1-598b896c9d-wxrrw <span style="color: green;">1/1</span> Running 0 81s

# ...

#

# NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE

# service/details <span style="color: green;">ClusterIP</span> 10.96.68.221 <none> 9080/TCP 81s

# service/kubernetes <span style="color: green;">ClusterIP</span> 10.96.0.1 <none> 443/TCP 92m

# service/productpage <span style="color: green;">ClusterIP</span> 10.96.86.254 <none> 9080/TCP 81s

# service/ratings <span style="color: green;">ClusterIP</span> 10.96.108.142 <none> 9080/TCP 81s

# service/reviews <span style="color: green;">ClusterIP</span> 10.96.47.199 <none> 9080/TCP 81s

#

# NAME ENDPOINTS AGE

# endpoints/details 172.20.1.185:9080 81s

# endpoints/kubernetes 192.168.10.100:6443 92m

# endpoints/productpage 172.20.1.100:9080 81s

# endpoints/ratings 172.20.1.247:9080 81s

# endpoints/reviews 172.20.1.114:9080,172.20.1.186:9080,172.20.1.232:9080 81s

# <span style="color: green;">👉 istio 와 다르게 사이드카 컨테이너가 없어서 파드가 1개의 (1/1) 컨테이너로 동작합니다. NodePort와 LoadBalancer 서비스도 없습니다.</span>

#

$ kc describe ingressclasses.networking.k8s.io

# => Name: cilium

# Labels: app.kubernetes.io/managed-by=Helm

# Annotations: meta.helm.sh/release-name: cilium

# meta.helm.sh/release-namespace: kube-system

# Controller: cilium.io/ingress-controller

# Events: <none>

$ kubectl get ingressclasses.networking.k8s.io

# => NAME CONTROLLER PARAMETERS AGE

# cilium cilium.io/ingress-controller <none> 94m

# Basic ingress for istio bookinfo demo application, which can be found in below

$ cat << EOF | kubectl apply -f -

apiVersion: networking.k8s.io/v1

kind: Ingress

metadata:

name: basic-ingress

namespace: default

spec:

ingressClassName: cilium

rules:

- http:

paths:

- backend:

service:

name: details

port:

number: 9080

path: /details

pathType: Prefix

- backend:

service:

name: productpage

port:

number: 9080

path: /

pathType: Prefix

EOF

# => ingress.networking.k8s.io/basic-ingress created

# Adress 는 cilium-ingress LoadBalancer 의 EX-IP

$ kubectl get svc -n kube-system cilium-ingress

# => NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE

# cilium-ingress LoadBalancer 10.96.58.190 192.168.10.211 80:32243/TCP,443:30329/TCP 95m

$ kubectl get ingress

# => NAME CLASS HOSTS ADDRESS PORTS AGE

# basic-ingress cilium * 192.168.10.211 80 34s

$ kc describe ingress

# => ...

# Rules:

# Host Path Backends

# ---- ---- --------

# *

# /details details:9080 (172.20.1.185:9080)

# / productpage:9080 (172.20.1.100:9080)

# 호출 확인

$ LBIP=$(kubectl get svc -n kube-system cilium-ingress -o jsonpath='{.status.loadBalancer.ingress[0].ip}')

$ echo $LBIP

# => 192.168.10.211

# 실패하는 호출이 있는가?

$ curl -so /dev/null -w "%{http_code}\n" http://$LBIP/

# => 200

$ curl -so /dev/null -w "%{http_code}\n" http://$LBIP/details/1

# => 200

$ curl -so /dev/null -w "%{http_code}\n" http://$LBIP/ratings

# => 404

# <span style="color: green;">👉 실패하였습니다. 앞서 살펴본 ingress 룰에는 /ratings가 없고, `/`를 담당하는 productpage에서도 처리하지 않는 URL이기 때문입니다.</span>

# Access the Bookinfo application

$ curl "http://$LBIP/productpage?u=normal"

# 모니터링

$ cilium hubble port-forward&

# => ℹ️ Hubble Relay is available at 127.0.0.1:4245

$ hubble observe -f -t l7

# or

# $ hubble observe -f --identity ingress

# => ...

# router에서 호출

$ curl -so /dev/null -w "%{http_code}\n" http://$LBIP/

# => 200

$ curl -so /dev/null -w "%{http_code}\n" http://$LBIP/details/1

# => 200

$ sshpass -p 'vagrant' ssh vagrant@router curl -s http://$LBIP/

$ sshpass -p 'vagrant' ssh vagrant@router curl -s http://$LBIP/details/1 -v

# => ...

# < server: envoy

# < date: Sat, 23 Aug 2025 07:06:51 GMT

# < content-length: 178

# < x-envoy-upstream-service-time: 18

$ sshpass -p 'vagrant' ssh vagrant@router curl -s http://$LBIP/ratings

# => <!doctype html>

# <html lang=en>

# <title>404 Not Found</title>

# <h1>Not Found</h1>

# <p>The requested URL was not found on the server. If you entered the URL manually please check your spelling and try again.</p>

# productpage-v1 파드가 배포된 노드 확인

$ kubectl get pod -l app=productpage -owide

# => NAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE READINESS GATES

# productpage-v1-54bb874995-5zh9b 1/1 Running 0 17m 172.20.1.100 k8s-w1 <none> <none>

# 해당 노드(k8s-w1)에서 veth 인터페이스 정보 확인

$ sshpass -p 'vagrant' ssh vagrant@k8s-w1

---

$ PROID=172.20.1.100

$ ip route |grep $PROID

# => 172.20.1.100 dev <span style="color: green;">lxcdd0576ed651e</span> proto kernel scope link

$ PROVETH=lxcdd0576ed651e

# ngrep 로 veth 트래픽 캡쳐 : productpage 는 9080 TCP Port 사용

$ ngrep -tW byline -d $PROVETH '' 'tcp port 9080'

# 외부에서 호출 시도

$ sshpass -p 'vagrant' ssh vagrant@router curl -s http://$LBIP

# ngrep 로 veth 트래픽 캡쳐 : productpage 는 9080 TCP Port 사용

$ ngrep -tW byline -d $PROVETH '' 'tcp port 9080'

# => <span style="color: green;">## igress(envoy) 가 XFF에 client-ip 담고, 목적지 파드로 요청</span>

# T 2025/08/23 16:10:12.309006 10.0.2.15:32780 -> 172.20.1.100:9080 [AP] #4

# GET / HTTP/1.1.

# host: 192.168.10.211.

# user-agent: curl/8.5.0.

# accept: */*.

# <span style="color: green;">x-forwarded-for: 192.168.10.200.</span>

# x-forwarded-proto: http.

# x-envoy-internal: true.

# x-request-id: 6d2bda20-5f73-41d3-ac90-159cd56a2386.

# .

#

# <span style="color: green;">## igress(envoy)로 리턴하는 트래픽</span>

# T 2025/08/23 16:10:12.325238 172.20.1.100:9080 -> 10.0.2.15:32780 [AP] #6

# HTTP/1.1 200 OK.

# Server: gunicorn.

# Date: Sat, 23 Aug 2025 07:10:12 GMT.

# Connection: keep-alive.

# Content-Type: text/html; charset=utf-8.

# Content-Length: 2080.

Ingress-Nginx 설치하여 Cilium Ingress와 공존 가능여부 확인

- 이번에는 Cilium ingress와 Ingress-Nginx가 동시에 활성화 될 수 있는지 확인해보겠습니다.

# Ingress-Nginx 컨트롤러 설치

$ helm repo add ingress-nginx https://kubernetes.github.io/ingress-nginx

# => "ingress-nginx" has been added to your repositories

$ helm install ingress-nginx ingress-nginx/ingress-nginx --create-namespace -n ingress-nginx

# => NAME: ingress-nginx

# LAST DEPLOYED: Sat Aug 23 16:18:18 2025

# NAMESPACE: ingress-nginx

# STATUS: deployed

# REVISION: 1

# TEST SUITE: None

# NOTES:

# The ingress-nginx controller has been installed.

# It may take a few minutes for the load balancer IP to be available.

# ...

# 확인

$ kubectl get all -n ingress-nginx

# => NAME READY STATUS RESTARTS AGE

# pod/ingress-nginx-controller-67bbdf7d8d-qmtp2 1/1 Running 0 34s

#

# NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE

# service/ingress-nginx-controller LoadBalancer 10.96.45.145 192.168.10.212 80:32426/TCP,443:30289/TCP 35s

# service/ingress-nginx-controller-admission ClusterIP 10.96.79.200 <none> 443/TCP 35s

#

# NAME READY UP-TO-DATE AVAILABLE AGE

# deployment.apps/ingress-nginx-controller 1/1 1 1 35s

#

# NAME DESIRED CURRENT READY AGE

# replicaset.apps/ingress-nginx-controller-67bbdf7d8d 1 1 1 34s

$ kc describe svc -n ingress-nginx ingress-nginx-controller

# => Name: ingress-nginx-controller

# Namespace: ingress-nginx

# ...

# LoadBalancer Ingress: 192.168.10.212 (VIP)

# Port: http 80/TCP

# TargetPort: http/TCP

# NodePort: http 32426/TCP

# Endpoints: 172.20.1.154:80

# Port: https 443/TCP

# TargetPort: https/TCP

# NodePort: https 30289/TCP

# Endpoints: 172.20.1.154:443

# ...

$ kubectl get svc -n ingress-nginx

# => NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE

# ingress-nginx-controller LoadBalancer 10.96.45.145 192.168.10.212 80:32426/TCP,443:30289/TCP 2m

# ingress-nginx-controller-admission ClusterIP 10.96.79.200 <none> 443/TCP 2m

$ kubectl get ingressclasses.networking.k8s.io

# => NAME CONTROLLER PARAMETERS AGE

# cilium cilium.io/ingress-controller <none> 121m

# nginx k8s.io/ingress-nginx <none> 2m6s

# ingress 설정

$ cat << EOF | kubectl apply -f -

apiVersion: networking.k8s.io/v1

kind: Ingress

metadata:

name: webpod-ingress-nginx

namespace: default

spec:

ingressClassName: nginx

rules:

- host: nginx.webpod.local

http:

paths:

- backend:

service:

name: webpod

port:

number: 80

path: /

pathType: Prefix

EOF

# => ingress.networking.k8s.io/webpod-ingress-nginx created

# ingress LB EX-IP 할당 까지 다소 시간 소요..

$ kubectl get ingress -w

# => NAME CLASS HOSTS ADDRESS PORTS AGE

# basic-ingress cilium * 192.168.10.211 80 29m

# webpod-ingress-nginx nginx nginx.webpod.local <span style="color: green;">192.168.10.212</span> 80 32s

#

$ LB2IP=$(kubectl get svc -n ingress-nginx ingress-nginx-controller -o jsonpath='{.status.loadBalancer.ingress[0].ip}')

$ echo $LB2IP

# => 192.168.10.211

$ curl $LB2IP

# => <html>

# <head><title>404 Not Found</title></head>

# ...

# <span style="color: green;">👉 nginx.webpod.local 호스트명이 없어서 404 에러 발생</span>

$ curl -H "Host: nginx.webpod.local" $LB2IP

# => Hostname: webpod-697b545f57-b5vtj

# IP: 172.20.0.70

# RemoteAddr: 172.20.1.154:40984

# GET / HTTP/1.1

# Host: nginx.webpod.local

# User-Agent: curl/8.5.0

# Accept: */*

# X-Forwarded-For: <span style="color: green;">192.168.10.100</span>

# ...

$ curl -H "Host: nginx.webpod.local" $LB2IP

# => Hostname: webpod-697b545f57-jp4wc

# IP: 172.20.1.206

# RemoteAddr: 172.20.1.154:48320

# GET / HTTP/1.1

# Host: nginx.webpod.local

# User-Agent: curl/8.5.0

# Accept: */*

# X-Forwarded-For: 192.168.10.100

# ...

$ sshpass -p 'vagrant' ssh vagrant@router "curl -s -H 'Host: nginx.webpod.local' $LB2IP"

# => Hostname: webpod-697b545f57-jp4wc

# ...

# X-Forwarded-For: 192.168.10.200

# ...

$ sshpass -p 'vagrant' ssh vagrant@router "curl -s -H 'Host: nginx.webpod.local' $LB2IP"

# => Hostname: webpod-697b545f57-b5vtj

# ...

# X-Forwarded-For: 192.168.10.200

# ...

- Cilium Ingress와 Nginx ingress는 동시 활성화가 가능하며, 각각의 EX-IP로 정상 호출이 가능한 것을 확인할 수 있습니다.

Dedicated Mode

- Cilium Ingress는 기본적으로 Shared Mode로 동작합니다. Dedicated Mode로 변경하는 방법을 알아보겠습니다.

# Basic ingress for istio bookinfo demo application, which can be found in below

$ cat << EOF | kubectl apply -f -

apiVersion: networking.k8s.io/v1

kind: Ingress

metadata:

name: webpod-ingress

namespace: default

annotations:

ingress.cilium.io/loadbalancer-mode: dedicated

spec:

ingressClassName: cilium

rules:

- http:

paths:

- backend:

service:

name: webpod

port:

number: 80

path: /

pathType: Prefix

EOF

# => ingress.networking.k8s.io/webpod-ingress created

#

$ kc describe ingress webpod-ingress

# => Name: webpod-ingress

# Labels: <none>

# Namespace: default

# Address: 192.168.10.213

# Ingress Class: cilium

# Default backend: <default>

# Rules:

# Host Path Backends

# ---- ---- --------

# *

# / webpod:80 (172.20.1.206:80,172.20.0.70:80)

# Annotations: ingress.cilium.io/loadbalancer-mode: <span style="color: green;">dedicated</span>

$ kubectl get ingress

# => NAME CLASS HOSTS ADDRESS PORTS AGE

# basic-ingress cilium * 192.168.10.211 80 45m

# <span style="color: green;">webpod-ingress</span> cilium * 192.168.10.213 80 29s

# webpod-ingress-nginx nginx nginx.webpod.local 192.168.10.212 80 16m

$ kubectl get svc,ep cilium-ingress-webpod-ingress

# => NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE

# service/cilium-ingress-webpod-ingress LoadBalancer 10.96.153.108 192.168.10.213 80:30159/TCP,443:30408/TCP 50s

#

# NAME ENDPOINTS AGE

# endpoints/cilium-ingress-webpod-ingress 192.192.192.192:9999 50s

# LB EX-IP에 대한 L2 Announcement 의 Leader 노드 확인

$ kubectl get lease -n kube-system | grep ingress

# => cilium-l2announce-default-cilium-ingress-webpod-ingress k8s-w1 80s

# cilium-l2announce-ingress-nginx-ingress-nginx-controller k8s-w1 21m

# cilium-l2announce-kube-system-cilium-ingress k8s-w1 58m

# webpod 파드 IP 확인

$ kubectl get pod -l app=webpod -owide

# => NAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE READINESS GATES

# webpod-697b545f57-b5vtj 1/1 Running 0 12m 172.20.0.70 k8s-ctr <none> <none>

# webpod-697b545f57-jp4wc 1/1 Running 0 12m 172.20.1.206 k8s-w1 <none> <none>

# k8c-ctr, k8s-w1 노드에서 파드 IP에 veth 찾기(ip -c route) 이후 ngrep 로 각각 트래픽 캡쳐

$ sshpass -p 'vagrant' ssh vagrant@k8s-ctr

---

$ ip route | grep 172.20.0.70

# => 172.20.0.70 dev lxc148c311965e6 proto kernel scope link

$ WPODVETHCTR=lxc148c311965e6

$ ngrep -tW byline -d $WPODVETHCTR '' 'tcp port 80'

# => lxc148c311965e6: no IPv4 address assigned: Cannot assign requested address

# interface: lxc148c311965e6

# filter: ( tcp port 80 ) and ((ip || ip6) || (vlan && (ip || ip6)))

# ###

# T 2025/08/23 16:48:28.123959 172.20.0.70:80 -> 172.20.1.60:40517 [AP] #3

# HTTP/1.1 200 OK.

# Date: Sat, 23 Aug 2025 07:48:28 GMT.

# Content-Length: 343.

# Content-Type: text/plain; charset=utf-8.

# .

# Hostname: webpod-697b545f57-b5vtj

# IP: 127.0.0.1

# IP: ::1

# IP: 172.20.0.70

# IP: fe80::d46d:b0ff:fe0d:619a

# RemoteAddr: 172.20.1.60:40517

# GET / HTTP/1.1.

# Host: 192.168.10.213.

# User-Agent: curl/8.5.0.

# Accept: */*.

# X-Envoy-Internal: true.

# X-Forwarded-For: 192.168.10.200.

# X-Forwarded-Proto: http.

# X-Request-Id: 01bd1da4-e1f1-47e7-958d-1032c55ec11b.

# ...

---

$ sshpass -p 'vagrant' ssh vagrant@k8s-w1

---

$ ip route | grep 172.20.1.206

# => 172.20.1.206 dev lxc9e0d1071b53f proto kernel scope link

$ WPODVETHW1=lxc9e0d1071b53f

$ ngrep -tW byline -d $WPODVETHW1 '' 'tcp port 80'

# => lxc9e0d1071b53f: no IPv4 address assigned: Cannot assign requested address

# interface: lxc9e0d1071b53f

# filter: ( tcp port 80 ) and ((ip || ip6) || (vlan && (ip || ip6)))

# ####

# T 2025/08/23 16:48:29.296230 10.0.2.15:34958 -> 172.20.1.206:80 [AP] #4

# GET / HTTP/1.1.

# host: 192.168.10.213.

# user-agent: curl/8.5.0.

# accept: */*.

# x-forwarded-for: 192.168.10.200.

# x-forwarded-proto: http.

# x-envoy-internal: true.

# x-request-id: 80e8099d-b64b-4f05-805e-72a4d670024f.

# .

#

# ##

# T 2025/08/23 16:48:29.300200 172.20.1.206:80 -> 10.0.2.15:34958 [AP] #6

# HTTP/1.1 200 OK.

# Date: Sat, 23 Aug 2025 07:48:29 GMT.

# Content-Length: 342.

# Content-Type: text/plain; charset=utf-8.

# .

# Hostname: webpod-697b545f57-jp4wc

# IP: 127.0.0.1

# IP: ::1

# IP: 172.20.1.206

# IP: fe80::a4ee:c1ff:fed4:b3c3

# RemoteAddr: 10.0.2.15:34958

# GET / HTTP/1.1.

# Host: 192.168.10.213.

# User-Agent: curl/8.5.0.

# Accept: */*.

# X-Envoy-Internal: true.

# X-Forwarded-For: 192.168.10.200.

# X-Forwarded-Proto: http.

# X-Request-Id: 80e8099d-b64b-4f05-805e-72a4d670024f.

# ...

---

# router 에서 호출 확인

$ LB2IP=$(kubectl get svc cilium-ingress-webpod-ingress -o jsonpath='{.status.loadBalancer.ingress[0].ip}')

$ sshpass -p 'vagrant' ssh vagrant@router curl -s http://$LB2IP

# => Hostname: webpod-697b545f57-jp4wc

# IP: 127.0.0.1

# IP: ::1

# IP: 172.20.1.206

# IP: fe80::a4ee:c1ff:fed4:b3c3

# RemoteAddr: 10.0.2.15:34958 # webpod 인입 시 S.IP : 마치 L2 Leader 노드에 webpod로 전달되어, 소스IP가 해당 노드의 첫 번째 NIC IP,

# GET / HTTP/1.1

# Host: 192.168.10.213

# User-Agent: curl/8.5.0

# Accept: */*

# X-Envoy-Internal: true

# X-Forwarded-For: 192.168.10.200

# X-Forwarded-Proto: http

# X-Request-Id: 80e8099d-b64b-4f05-805e-72a4d670024f

$ sshpass -p 'vagrant' ssh vagrant@router curl -s http://$LB2IP

# => Hostname: webpod-697b545f57-b5vtj

# IP: 127.0.0.1

# IP: ::1

# IP: 172.20.0.70

# IP: fe80::d46d:b0ff:fe0d:619a

# RemoteAddr: 172.20.1.60:40517 # webpod 인입 시 S.IP : L2 Leader 노드(k8s-w1)에서 다른 노드에 파드로 전달되어, ingress 예약IP로 SNAT

# GET / HTTP/1.1

# Host: 192.168.10.213

# User-Agent: curl/8.5.0

# Accept: */*

# X-Envoy-Internal: true

# X-Forwarded-For: 192.168.10.200

# X-Forwarded-Proto: http

# X-Request-Id: 01bd1da4-e1f1-47e7-958d-1032c55ec11b

Ingress and Network Policies Example

# 클러스터 전체(모든 네임스페이스)에 적용되는 정책 : 참고로 아래 정책 적용 후 Hubble-ui 로 접속 불가!

$ cat << EOF | kubectl apply -f -

apiVersion: "cilium.io/v2"

kind: CiliumClusterwideNetworkPolicy

metadata:

name: "external-lockdown"

spec:

description: "Block all the traffic originating from outside of the cluster"

endpointSelector: {}

ingress:

- fromEntities:

- cluster

EOF

# => ciliumclusterwidenetworkpolicy.cilium.io/external-lockdown created

$ kubectl get ciliumclusterwidenetworkpolicy

# => NAME VALID

# external-lockdown True

#

$ curl --fail -v http://"$LBIP"/details/1

# => < HTTP/1.1 403 Forbidden

#

$ hubble observe -f --identity ingress

## k8s-ctr 에서 curl 실행 시

# => Aug 23 08:10:11.770: 127.0.0.1:36726 (ingress) -> 127.0.0.1:15778 (world) http-request DROPPED (HTTP/1.1 GET http://192.168.10.211/details/1)

# Aug 23 08:10:11.770: 127.0.0.1:36726 (ingress) <- 127.0.0.1:15778 (world) http-response FORWARDED (HTTP/1.1 403 1ms (GET http://192.168.10.211/details/1))

## router 에서 curl 실행 시

# => Aug 23 08:10:20.475: 192.168.10.200:43490 (ingress) -> kube-system/cilium-ingress:80 (world) http-request DROPPED (HTTP/1.1 GET http://192.168.10.211/details/1)

# Aug 23 08:10:20.475: 192.168.10.200:43490 (ingress) <- kube-system/cilium-ingress:80 (world) http-response FORWARDED (HTTP/1.1 403 0ms (GET http://192.168.10.211/details/1))

# router와 k8s-ctr의 요청은 허용하는 정책 적용

$ cat << EOF | kubectl apply -f -

apiVersion: "cilium.io/v2"

kind: CiliumClusterwideNetworkPolicy

metadata:

name: "allow-cidr"

spec:

description: "Allow all the traffic originating from a specific CIDR"

endpointSelector:

matchExpressions:

- key: reserved:ingress

operator: Exists

ingress:

- fromCIDRSet:

# Please update the CIDR to match your environment

- cidr: 192.168.10.200/32

- cidr: 127.0.0.1/32

EOF

# => ciliumclusterwidenetworkpolicy.cilium.io/allow-cidr created

# 요청 성공! : k8s-ctr , router 모두 가능

$ curl --fail -v http://"$LBIP"/details/1

# => < HTTP/1.1 200 OK

$ sshpass -p 'vagrant' ssh vagrant@router "curl -s --fail -v http://"$LBIP"/details/1"

# => * Trying 192.168.10.211:80...

# * Connected to 192.168.10.211 (192.168.10.211) port 80

# > GET /details/1 HTTP/1.1

# > Host: 192.168.10.211

# > User-Agent: curl/8.5.0

# > Accept: */*

# >

# {"id":1,"author":"William Shakespeare","year":1595,"type":"paperback","pages":200,"publisher":"PublisherA","language":"English","ISBN-10":"1234567890","ISBN-13":"123-1234567890"}< HTTP/1.1 200 OK

# < content-type: application/json

# < server: envoy

# < date: Sat, 23 Aug 2025 08:11:39 GMT

# < content-length: 178

# < x-envoy-upstream-service-time: 16

# <

# { [178 bytes data]

# * Connection #0 to host 192.168.10.211 left intact

# Default Deny Ingress Policy : DNS쿼리와 kube-system내의 파드 제외 to deny all traffic by default

$ cat << EOF | kubectl apply -f -

apiVersion: cilium.io/v2

kind: CiliumClusterwideNetworkPolicy

metadata:

name: "default-deny"

spec:

description: "Block all the traffic (except DNS) by default"

egress:

- toEndpoints:

- matchLabels:

io.kubernetes.pod.namespace: kube-system

k8s-app: kube-dns

toPorts:

- ports:

- port: '53'

protocol: UDP

rules:

dns:

- matchPattern: '*'

endpointSelector:

matchExpressions:

- key: io.kubernetes.pod.namespace

operator: NotIn

values:

- kube-system

EOF

# => ciliumclusterwidenetworkpolicy.cilium.io/default-deny created

$ kubectl get ciliumclusterwidenetworkpolicy

# => NAME VALID

# allow-cidr True

# default-deny True

# external-lockdown True

# 요청

$ curl --fail -v http://"$LBIP"/details/1

# => < HTTP/1.1 403 Forbidden

$ sshpass -p 'vagrant' ssh vagrant@router "curl -s --fail -v http://"$LBIP"/details/1"

# => < HTTP/1.1 403 Forbidden

# ingress 를 통해서 인입 시 허용

$ cat << EOF | kubectl apply -f -

apiVersion: cilium.io/v2

kind: CiliumClusterwideNetworkPolicy

metadata:

name: allow-ingress-egress

spec:

description: "Allow all the egress traffic from reserved ingress identity to any endpoints in the cluster"

endpointSelector:

matchExpressions:

- key: reserved:ingress

operator: Exists

egress:

- toEntities:

- cluster

EOF

# => ciliumclusterwidenetworkpolicy.cilium.io/allow-ingress-egress created

$ kubectl get ciliumclusterwidenetworkpolicy

# => NAME VALID

# allow-cidr True

# allow-ingress-egress True

# default-deny True

# external-lockdown True

#

$ curl --fail -v http://"$LBIP"/details/1

# => < HTTP/1.1 200 OK

$ sshpass -p 'vagrant' ssh vagrant@router "curl -s --fail -v http://"$LBIP"/details/1"

# => * Trying 192.168.10.211:80...

# * Connected to 192.168.10.211 (192.168.10.211) port 80

# > GET /details/1 HTTP/1.1

# > Host: 192.168.10.211

# > User-Agent: curl/8.5.0

# > Accept: */*

# >

# {"id":1,"author":"William Shakespeare","year":1595,"type":"paperback","pages":200,"publisher":"PublisherA","language":"English","ISBN-10":"1234567890","ISBN-13":"123-1234567890"}< HTTP/1.1 200 OK

# < content-type: application/json

# < server: envoy

# < date: Sat, 23 Aug 2025 08:13:20 GMT

# < content-length: 178

# < x-envoy-upstream-service-time: 8

# <

# { [178 bytes data]

# * Connection #0 to host 192.168.10.211 left intact

# 정책 삭제

$ kubectl delete CiliumClusterwideNetworkPolicy --all

# => ciliumclusterwidenetworkpolicy.cilium.io "allow-cidr" deleted

# ciliumclusterwidenetworkpolicy.cilium.io "allow-ingress-egress" deleted

# ciliumclusterwidenetworkpolicy.cilium.io "default-deny" deleted

# ciliumclusterwidenetworkpolicy.cilium.io "external-lockdown" deleted

Ingress Path Type Example

# Apply the base definitions

$ kubectl apply -f https://raw.githubusercontent.com/cilium/cilium/main/examples/kubernetes/servicemesh/ingress-path-types.yaml

# => ...

# deployment.apps/implpath2 created

# ...

# service/implpath2 created

# 확인

$ kubectl get -f https://raw.githubusercontent.com/cilium/cilium/main/examples/kubernetes/servicemesh/ingress-path-types.yaml

# => NAME READY UP-TO-DATE AVAILABLE AGE

# deployment.apps/exactpath 1/1 1 1 18s

# deployment.apps/prefixpath 1/1 1 1 18s

# deployment.apps/prefixpath2 1/1 1 1 18s

# deployment.apps/implpath 1/1 1 1 18s

# deployment.apps/implpath2 1/1 1 1 18s

#

# NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE

# service/prefixpath ClusterIP 10.96.11.159 <none> 80/TCP 18s

# service/prefixpath2 ClusterIP 10.96.158.98 <none> 80/TCP 18s

# service/exactpath ClusterIP 10.96.46.141 <none> 80/TCP 18s

# service/implpath ClusterIP 10.96.88.45 <none> 80/TCP 18s

# service/implpath2 ClusterIP 10.96.18.242 <none> 80/TCP 18s

# Apply the Ingress

$ kubectl apply -f https://raw.githubusercontent.com/cilium/cilium/main/examples/kubernetes/servicemesh/ingress-path-types-ingress.yaml

# => ingress.networking.k8s.io/multiple-path-types created

# 확인

$ kc describe ingress multiple-path-types

# => Rules:

# Host Path Backends

# ---- ---- --------

# pathtypes.example.com

# /exact exactpath:80 (172.20.1.238:3000)

# / prefixpath:80 (172.20.1.72:3000)

# /prefix prefixpath2:80 (172.20.1.176:3000)

# /impl implpath:80 (172.20.1.210:3000)

# /impl.+ implpath2:80 (172.20.1.223:3000)

$ kc get ingress multiple-path-types -o yaml

# => ...

# spec:

# ingressClassName: cilium

# rules:

# - host: pathtypes.example.com

# http:

# paths:

# - backend:

# service:

# name: exactpath

# port:

# number: 80

# path: /exact

# pathType: Exact

# - backend:

# service:

# name: prefixpath

# port:

# number: 80

# path: /

# pathType: Prefix

# - backend:

# service:

# name: prefixpath2

# port:

# number: 80

# path: /prefix

# pathType: Prefix

# - backend:

# service:

# name: implpath

# port:

# number: 80

# path: /impl

# pathType: ImplementationSpecific

# - backend:

# service:

# name: implpath2

# port:

# number: 80

# path: /impl.+

# pathType: ImplementationSpecific

# 호출 확인

$ export PATHTYPE_IP=`k get ing multiple-path-types -o json | jq -r '.status.loadBalancer.ingress[0].ip'`

$ curl -s -H "Host: pathtypes.example.com" http://$PATHTYPE_IP/ | jq

# => {

# "path": "/",

# "host": "pathtypes.example.com",

# "method": "GET",

# ...

# "X-Envoy-Internal": [

# "true"

# ],

# "X-Forwarded-For": [

# "10.0.2.15"

# ],

# ...

# 파드명 이름 확인

$ kubectl get pod | grep path

# => exactpath-7488f8c6c6-4w7rx 1/1 Running 0 2m7s

# implpath-7d8bf85676-qz6t6 1/1 Running 0 2m7s

# implpath2-56c97c8556-mv66q 1/1 Running 0 2m7s

# prefixpath-5d6b989d4-kwvv6 1/1 Running 0 2m7s

# prefixpath2-b7c7c9568-br2nl 1/1 Running 0 2m7s

# Should show prefixpath

$ curl -s -H "Host: pathtypes.example.com" http://$PATHTYPE_IP/ | grep -E 'path|pod'

# => "path": "/",

# "host": "pathtypes.example.com",

# "pod": "prefixpath-5d6b989d4-kwvv6"

# Should show exactpath

$ curl -s -H "Host: pathtypes.example.com" http://$PATHTYPE_IP/exact | grep -E 'path|pod'

# => "path": "/exact",

# "host": "pathtypes.example.com",

# "pod": "exactpath-7488f8c6c6-4w7rx"

# Should show prefixpath2

$ curl -s -H "Host: pathtypes.example.com" http://$PATHTYPE_IP/prefix | grep -E 'path|pod'

# => "path": "/prefix",

# "host": "pathtypes.example.com",

# "pod": "prefixpath2-b7c7c9568-br2nl"

# Should show implpath

$ curl -s -H "Host: pathtypes.example.com" http://$PATHTYPE_IP/impl | grep -E 'path|pod'

# => "path": "/impl",

# "host": "pathtypes.example.com",

# "pod": "implpath-7d8bf85676-qz6t6"

# Should show implpath2

$ curl -s -H "Host: pathtypes.example.com" http://$PATHTYPE_IP/implementation | grep -E 'path|pod'

# => "path": "/implementation",

# "host": "pathtypes.example.com",

# "pod": "implpath2-56c97c8556-mv66q"

# 삭제

$ kubectl delete -f https://raw.githubusercontent.com/cilium/cilium/main/examples/kubernetes/servicemesh/ingress-path-types.yaml

$ kubectl delete -f https://raw.githubusercontent.com/cilium/cilium/main/examples/kubernetes/servicemesh/ingress-path-types-ingress.yaml

Ingress Example with TLS Termination

TLS 인증서와 개인키 생성 : mkcert - Github

-

mkcert는 로컬 개발 환경에서 신뢰할 수 있는 SSL 인증서를 쉽게 생성할 수 있도록 도와주는 도구입니다.

# For demonstration purposes we will use a TLS certificate signed by a made-up, self-signed certificate authority (CA).

# One easy way to do this is with mkcert. We want a certificate that will validate bookinfo.cilium.rocks and hipstershop.cilium.rocks, as these are the host names used in this example.

$ apt install mkcert -y

$ mkcert -h

# => Usage of mkcert:

#

# $ mkcert -install

# Install the local CA in the system trust store.

#

# $ mkcert example.org

# Generate "example.org.pem" and "example.org-key.pem".

#

# $ mkcert example.com myapp.dev localhost 127.0.0.1 ::1

# Generate "example.com+4.pem" and "example.com+4-key.pem".

#